打ち込み、同期モノでのライブといえば、クリックを聞きながら、それに合わせて演奏するというのが常識です。「ノリが出せなくなる」、「ミスると取り返しがつかない」などなど問題は多々あるけれど、それが現実であり、ほかに手段がなく、またそれが同期モノの面白さでもあったわけです。

しかし、もし人が叩くドラムにシーケンサ側が合わせてくれることができたらどうでしょうか?従来の常識はすべて覆ることになり、今後のライブのあり方が大きく変わる可能性がでてきるのではないでしょうか?まだプロトタイプではあるけれど、そんなシステム、SYNCHLOiD(シンクロイド)というものが、日本大学芸術学部(以下、日芸)から生まれました。

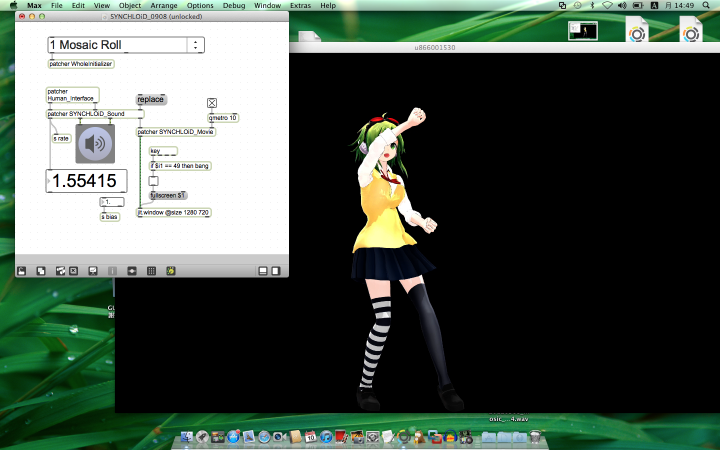

9月2日、SYNCHLOiDを用いて行われたライブ「GUMIの日大感謝祭」

9月2日、SYNCHLOiDを用いて行われたライブ「GUMIの日大感謝祭」

私自身が、このSYNCHLOiDの存在を知ったのは、9月2日。たまたまTwitterを見ていて「GUMIの日大感謝祭」なるものがニコ生で放送されていたのを知り、ふと見てみたのがキッカケです。お世辞にもキレイな動画というわけではなかったのですが、何か妙なのでちょっと説明を聞いてみると、人のドラムに合わせてVOCALOIDのMegpoidが歌い、それと同時にステージ上のスクリーンでMegpoidのキャラクタ、GUMIが踊るというのです。

「GUMIの日大感謝祭」の様子

その模様をまとめた映像が、先日ニコニコ動画にもアップされたので、それを見れば雰囲気はわかると思います。また、「GUMIの日大感謝祭」以前に、アップされていた初音ミクを用いた約1分のビデオのほうが、同期の雰囲気は分かりやすいかもしれません。

SYNCHLOiDを分かりやすく紹介する1分のデモビデオ

どうですか?ちょっと驚きですよね。神保彰さんによる「ドラム・トリガー・システム」を用いた「ワンマン・オーケストラ」というものはありましたが、あれは鬼才、神保さんだからできる技。1発ミスったらOUTというものではなく、SYNCHLOiDは、初心者ドラマの下手なリズムにも合わせることが可能という画期的なシステムなのです。

ちなみに、本題から外れるので、今回は割愛しますが、網戸(?)のようなスクリーン=「アミッドスクリーン」に投影されるシステム、「アミドロイド」のほうも同じく、日芸のアミッドP (@AOKI_KC) こと青木敬士先生が開発したものだそうです。そう、「GUMIの日大感謝祭」は「GUMIの日、大感謝祭」と読むより「GUMIの日大、感謝祭」とも読めるわけで、日芸の学術発表会的なニュアンスを持ったライブだったのです。

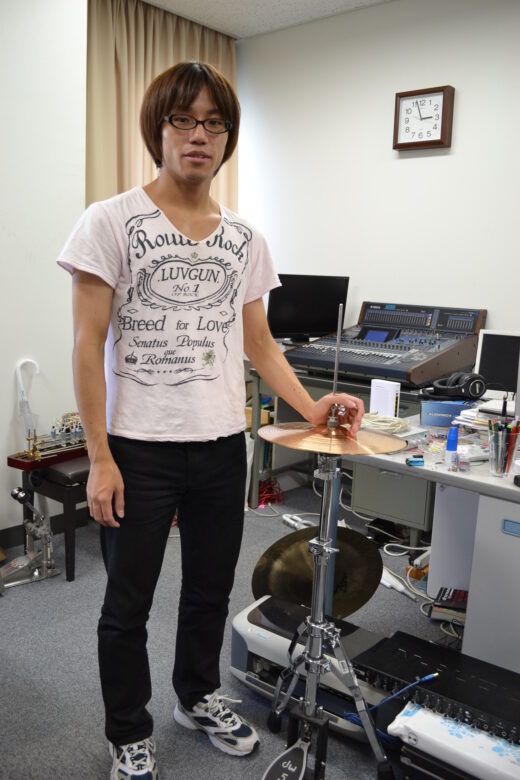

取材に応じてくれたSYNCHLOiDの開発者、なヲタさん

取材に応じてくれたSYNCHLOiDの開発者、なヲタさん

で、今回の主題であるSYNCHLOiDを開発したのは、このライブでドラムを叩いていた、日芸の大学院生、音楽芸術専攻情報音楽研究室の、なヲタ(@nawota1105)さん。

ライブ終了後、人づてにTwitterを介して連絡をしたところ、すぐに取材OKのお返事をいただいたので、SYNCHLOiDとはいったいどんなものなのか、どんな経緯で開発したのかなど、話を聞いてきました。

「僕自身は大学に入ってからドラムを始めました。クリックを聞きながら同期演奏するということもやりましたが、これが簡単じゃない。どうにかならないものだろうかと思っていた中、3年のとき人にシステムを同期させるものが作れないかと取り掛かったのです」と、なヲタさん。ただ、当時はプログラムに関する経験、知識も少なく、一度断念。しかし、その後大学で研究していた「リズムの揺らぎ」が応用できないだろうかと、4年生の後半になって再びチャレンジ。卒論のテーマとして取り組んでみたところ、あっさり完成してしまったのが、このSYNCHLOiDだというのです。

大学4年の卒論のテーマとしてSYNCHLOiDを開発したという、なヲタさん

大学4年の卒論のテーマとしてSYNCHLOiDを開発したという、なヲタさん

でも「リズムの揺らぎ」って何なのでしょうか?なヲタさんによれば「たとえばハイハットを8ビートで叩く場合、その叩き方で表と裏があります。その関係を時間的に見ていくと、ズレが生じ、そのズレを人が感知しながら修正していこうという流れがあるのです。それをここでは揺らぎと言っています」とのこと。

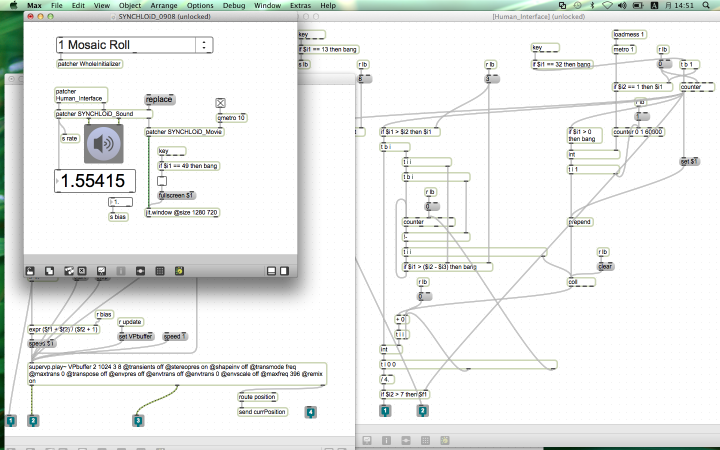

MAX/MSPを利用したシステムで、リズムの揺らぎを検出し、次のタイミングを予測する

MAX/MSPを利用したシステムで、リズムの揺らぎを検出し、次のタイミングを予測する

真剣に話を聞き始めると、学術的な難しい話になりそうなので、要点だけをまとめると「揺らぎに着目すると、演奏者の次に叩くタイミングが予想できるようになる。それに合わせてオーディオ・映像の再生速度を速くしたり、遅くするなどして追従させることで、このシステムができている」ということのようです。だからこそ、ドラムを叩く1打1打がクロックになるわけではなく、リズムとして捉えてビートを見出しているから実現できているわけです。

神保さんのワンマン・オーケストラとの決定的な違いは、ワンマン・オーケストラでは、叩くとそれをトリガーにシンセなどが演奏されるのに対し、SYNCHLOiDでは次の1手を予想して鳴らすようになっていること。そのため、音や映像に遅れは生じず(遅れがある場合は、予め調整してしまえばいい)、自然な演奏ができるのだそうです。とくにVOCALOIDと合わせる場合、トリガー後に鳴らすのだと、現実的に合わないという問題があるそうです。母音だけの音ならともかく、子音+母音の場合、実タイミングよりも前から鳴らさないと合わないからです。

「実際に作ると、しっかり動いてくれたのですが、あまりにうまく追従しすぎて、人間のミスすら正確に従ってくれるから、ちょっと怖いほどでした。ただ実際に鳴らしてみると、数値上はすごい追従をしているので、知覚上は案外普通に聞こえるし、裏と表がひっくり返るタイミングでも、あまり違和感なく聴こえますよ」とのこと。

大学の卒論で作った、SYNCHLOiD。名前をつけたのはつい最近だそうですが、4月のニコニコ超会議で行われた、ニコニコ学会(β)で「自発テンポによる同期演奏システム」として発表を行ったところ「野性の研究者大賞」を受賞したとのことでした。

ニコニコ超学会において「野生の研究者大賞」を受賞

ニコニコ超学会において「野生の研究者大賞」を受賞

ここで気になってくるのは、人の叩くリズムをどのように取り出すのか、という点。卒論では、ハイハットの叩く音をマイクで拾い、オーディオインターフェイスで取り込んで、ピークを検知するという方法を使っていたそうですが、実際のライブなどとなると、ほかの音も拾ってしまうので、問題が起こる可能性があるようです。直接センサーを取り付ける方法も試したけれど、なヲタさんとしてはできるだけ生楽器に対応できるように、いろいろ研究を続けているそうです。

ちなみに「GUMIの日大感謝祭」は、確実性重視ということで、ちょっとトリッキーな方法を用いていたのだとか。そう実は、なヲタさんのドラムに合わせていたのでしゃなく、別にトリガー担当者がいて、その人がなヲタさんのリズムを聞きながら鍵盤を叩き、それに合わせてSYNCHLOiDが動作する形になっていたそうです。この辺は、まだまだ研究、改良の余地はありそうですね。

そして、一番気になるのは、これが今後一般公開される可能性があるのか?という点です。これについて、最後に、なヲタさんに聞いてみました。

「SYNCHLOiDは、大学4年生のときに作ったシステム。またMAX/MSPというシステムを使いプロトタイプとして作ったものに過ぎません。今後、大学院の修士課程としてこの研究は続けていくつもりで、さらに発展させたものにしていくつもりです。そのときには、ぜひ多くの人たちに広く使ってもらえるシステムにしたいなと考えています」と語ってくれました。ぜひ、1日も早いシステムの公開を期待したいところですね。

【関連サイト】

GUMIの日大感謝祭

日本大学芸術学部音楽学科 情報音楽コース

江古田の音部屋~日本大学芸術学部音楽学科情報音楽コース川上央のブログ

コメント