ソニー系列の研究所であるソニーコンピュータサイエンス研究所(以下ソニーCSL)が2022年3月16日~18日の3日間、オープンハウス2022というイベントを実施しました。これはソニーCSLで活動する研究員が日頃の研究成果や活動を紹介する目的で、毎年秋に招待客に対して行ってきたイベントですが、今年はコロナ禍ということで、初のオンライン開催となるとともに、一般参加も可能な初めてのイベントとなりました。

その2日目は、音楽に関連する発表が3本あり、そのうちの一つが「Flow Machines : AIアシスト音楽制作」というプログラムでした。Flow MachinesとはAIを用いた自動作曲支援システムで、これまでもDTMステーションで何度か取り上げてきたので、ご存じの方も多いと思います。そのFlow Machinesとともに、ソニーCSLの技術を用いて作られたソニーミュージックの音楽制作ツール、Soundmainをテーマに、現状を紹介するとともに、AIを用いた音楽制作の未来について考えるパネルディスカッションとなったのです。実は、そのパネルディスカッションのモデレーターという形で私も参加したので、実際どんな内容だったのかその概要を紹介してみたいと思います。

3月17日、ソニーCSLのオープンハウス2022において「Flow Machines : AIアシスト音楽制作」というパネルディスカッションが行われた

3月17日、ソニーCSLのオープンハウス2022において「Flow Machines : AIアシスト音楽制作」というパネルディスカッションが行われた

ソニーCSLによるオープンハウス2022は、事前登録することでZoomへ参加できるとともに、YouTube Liveでもリアルタイム視聴できるという形で、3日間進められました。その2日目は「DAY2:Huma Augmentation &Creativetyと」と題され、ソニーCSLの副所長であり、東京大学大学院情報学環教授でもある暦本純一さんによるキーノートスピーチのあと、7つのプログラムが進められていきました。その中でも注目すべきが音楽系3つのプログラムです。具体的には

[2-4] Flow Machines : AIアシスト音楽制作

[2-5] Music Excellence Project :ミライの音楽教育と、クリエイティビティをサポートする仕組み

のそれぞれ。「生命科学・音楽・AIと異分野融合」においては、生命科学・AI・音楽の観点で、研究員のナターリア・ポリュリャーフさんと赤間健人さんがAGCTという生物データの解析ツールの話と、音楽データにも対応できるようにAGCT-Deepへと派生させた話を紹介していました。また「Music Excellence Project :ミライの音楽教育と、クリエイティビティをサポートする仕組み」では、音楽家の熟達支援と怪我の予防のための研究や開発であるダイナフォーミックスと、その成果に基づく音楽家のための身体教育プログラムPEAC(Physical Education for Artists Curriculum)の開発、そしてそれらを演奏や指導の現場に提供する社会実装のための各種プログラムとなっていました。

Zoomをつかったウェビナー形式で開催されると同時に、YouTubeLiveでも配信された

Zoomをつかったウェビナー形式で開催されると同時に、YouTubeLiveでも配信された

いずれも、YouTube Liveのアーカイブで見ることがでいるので、興味のある方はぜひご覧いただきたいのですが、ここでその内容をレポートするのは「Flow Machines : AIアシスト音楽制作」についてです。

今回は、Flow Machinesを開発したソニーCSLの岸治彦さん、Soundmainの担当者であるソニー・ミュージック エンタテインメントの後閑研一さん、音楽プロデューサーでRightTracksの代表取締役である菊地智敦さんとパネルディスカッション形式で話を進めていきました。

Flow Machinesについては、「実用レベルのAI作曲支援プラグインFlow Machines Professionalは、夢のツールになりえるのか!?Cubase上で実験される最先端技術」という記事や「ソニーCSLがAI作曲支援ツール、Flow MachinesのiPad版を無料でリリース」という記事でも取り上げていましたが、まずはこれについて岸さんがデモを交えながら、現状について紹介しています。

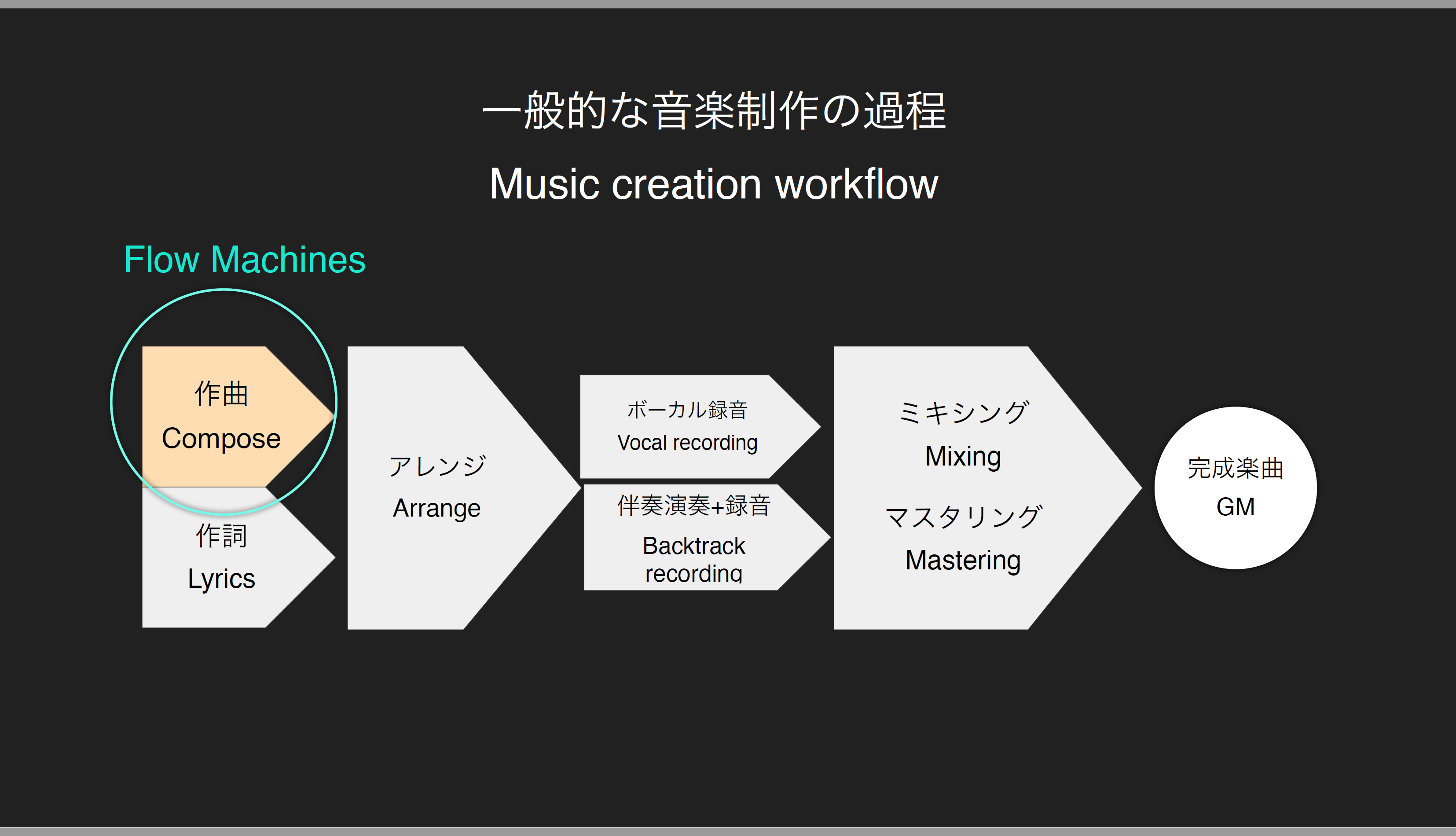

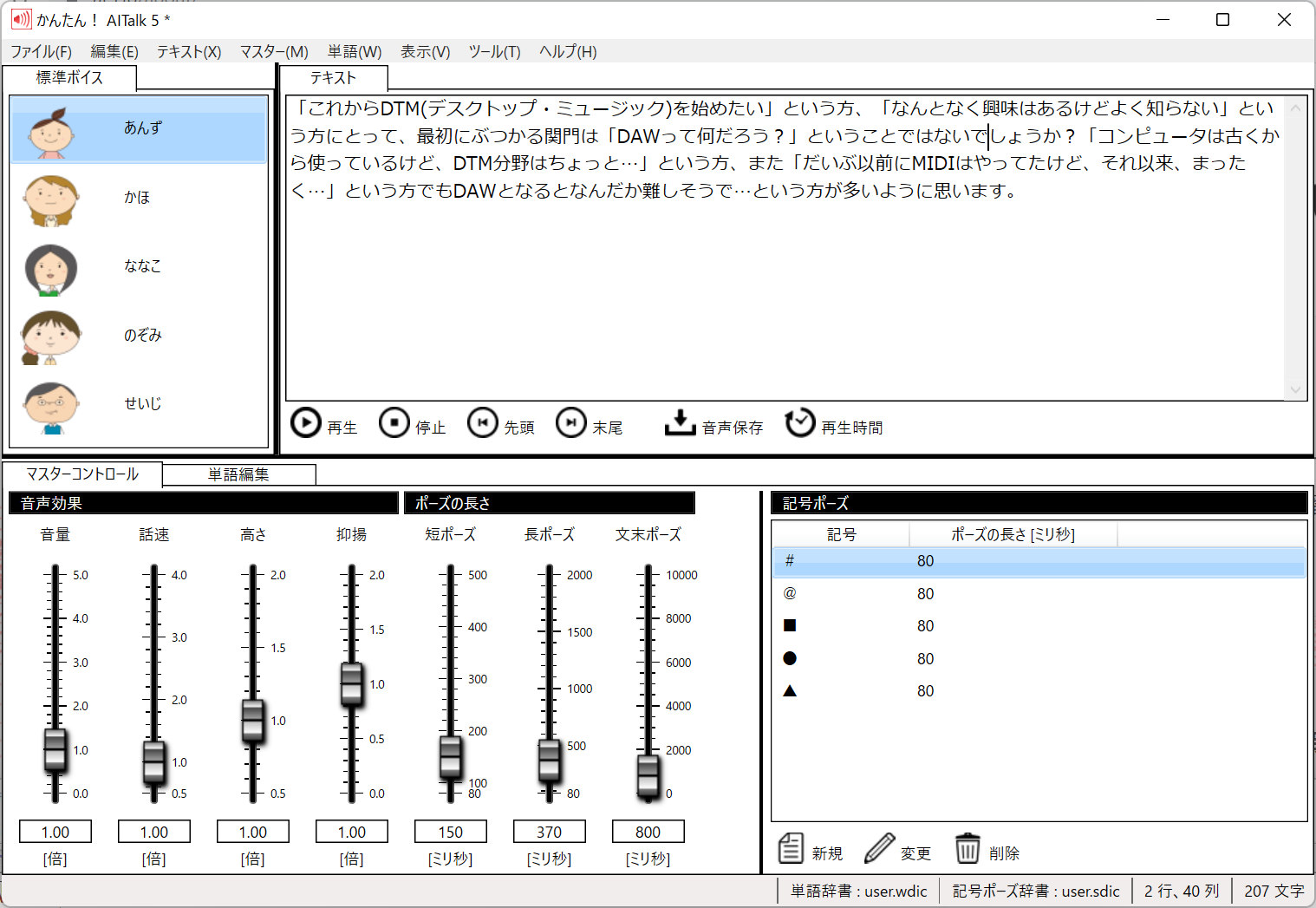

簡単にいうとFlow Machinesは音楽制作におけるさまざまな行程の中の作曲部分をAIが行うというもの。もちろん、人にとって替わろうというのではなく、AIでメロディーを提案し、それをクリエイターがヒントにして曲を仕上げていくというアシスタント的な役割です。

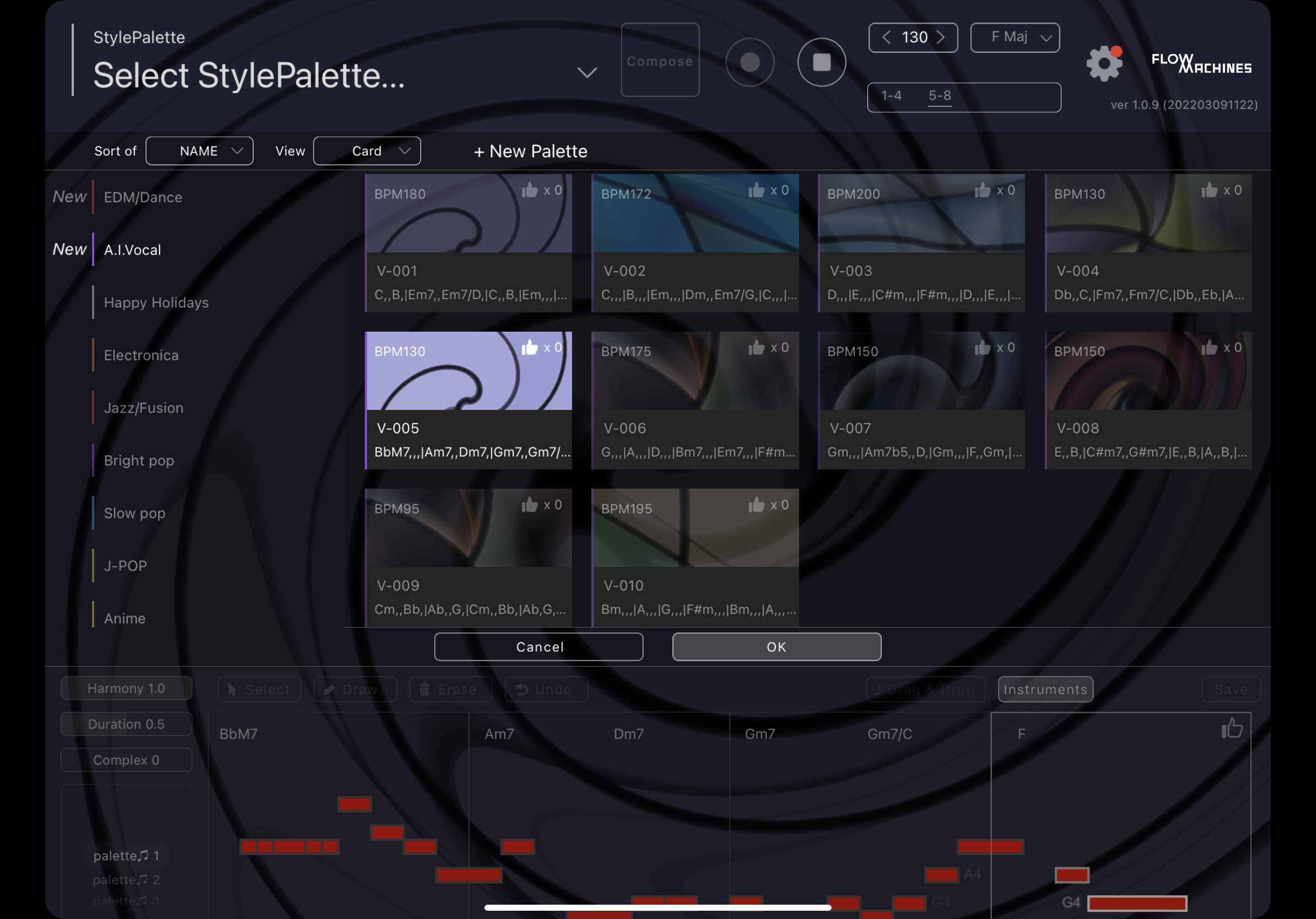

Flow Machinesには200を越えるStyle Paletteが用意されている

Flow Machinesには200を越えるStyle Paletteが用意されている

「ここにはStyle Palleteと呼ばれるデータが200種類以上入っているのですが、これはJ-POP、Jazz/Fusion、Electronica、Anime……とさまざまなジャンルごとに作られたFlow Machinesの学習データを意味しています。具体的にはメロディ、コード、ベースのMIDIデータで構成されており、これを元にユーザーは簡単にメロディーを自動生成することができ、何回か試してみて気に入ったものができたら、それをドラッグ&ドロップでDAWに持っていくことで、自分の曲に生かすことができる、というシステムになっています」と岸さん。

ソニーコンピュータサイエンス研究所の研究員でFlow Machinesプロジェクトを進めている岸治彦さん

ソニーコンピュータサイエンス研究所の研究員でFlow Machinesプロジェクトを進めている岸治彦さん

実はそのStyle PaletteはMP3によるバックトラックを元にクリエイターに10個くらいのメロディーを作ってもらい、それを機械学習させたものとなっています。そのため、生成されるメロディも、学習させたクリエイターのクセがいい感じに反映されるのだとか……。

音楽プロデューサーで株式会社ライトトラックス 代表取締役 菊地智敦さん

音楽プロデューサーで株式会社ライトトラックス 代表取締役 菊地智敦さん

でも、AIが作曲するとなると、それは人間にとって脅威とならないのか?この点について、菊地さんに伺ってみたところ「昔、ドラムマシンが登場してきたころ、将来ドラマーがいなくなるのでは……とすごく言われたことがありました。LAではドラマーがデモをしたりしてましたから。でも、今ではそんなことは言われないし、みんなが当たり前のようにドラムマシンを使っている一方で、ドラマーもしっかり活躍しています。ここでは、しっかりとした役割の棲み分けがされるようなったからで、AI作曲もそうなっていくのではないか、と考えています」と話していました。

一方で、今回のパネルディスカッションで私も初めてその存在を知ったのがSoundmainというサービス。これについては後閑さんに紹介してもらっています。

これは2019年4月に開発することが発表されたもので「AIやブロックチェーンなど、ソニーの先端テクノロジーを使って、音楽クリエイターの活動を支援する音楽制作プラットフォーム」とのこと。最初はブログからスタートし、その後、音楽制作用の素材を販売するSoundmain Storeをオープン。ここではドラム素材やベース素材などが販売されています。

ソニー・ミュージックエンタテインメントでSoundmainを担当する後閑 研一さん

ソニー・ミュージックエンタテインメントでSoundmainを担当する後閑 研一さん

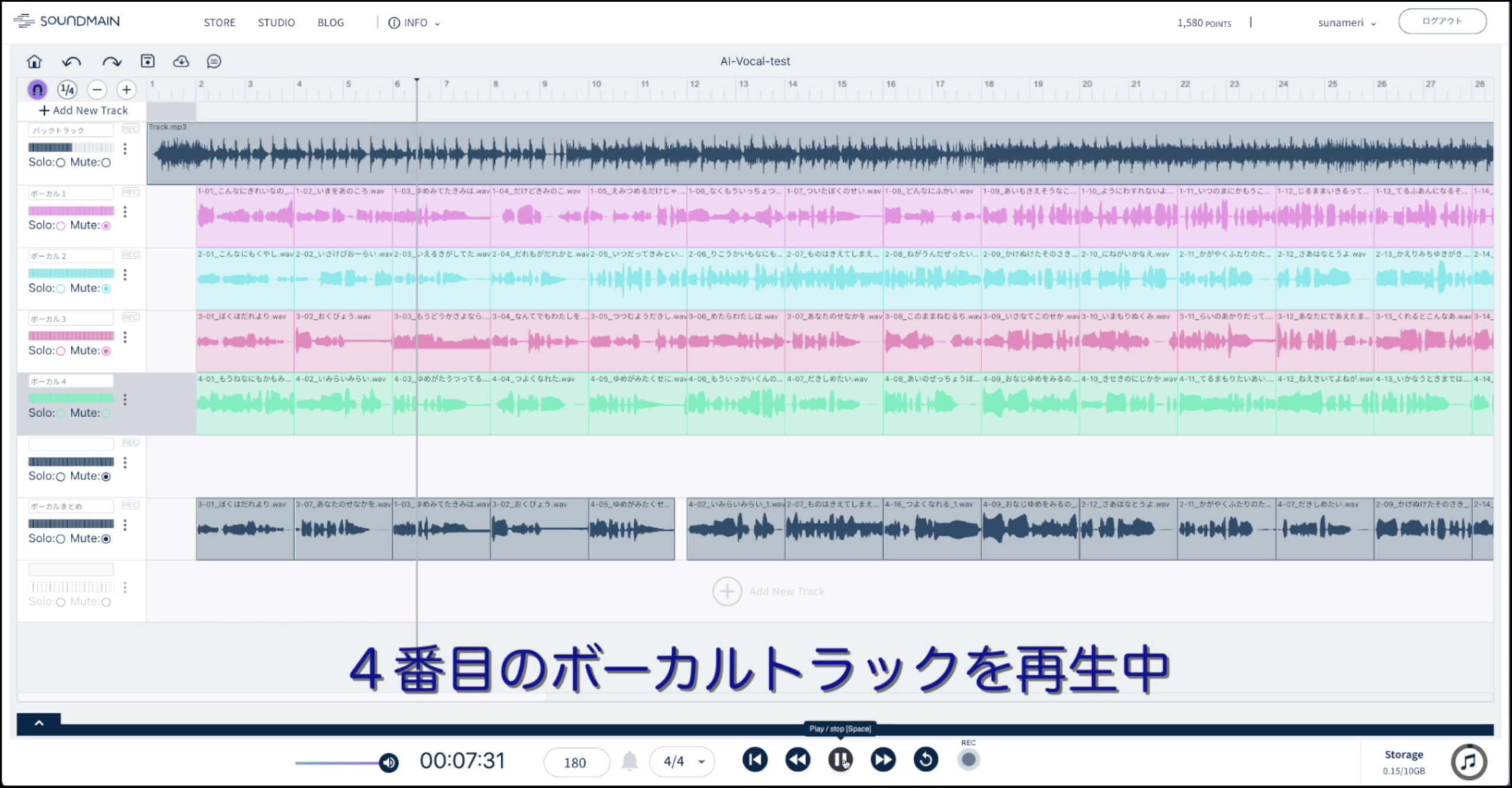

さらに2021年にスタートしたのがブラウザ上で動作するDAWともいえるSoundmain Studio。これはトラックにStoreで購入した素材のほか、WAVファイルを並べていくことで曲を作っていくことができるというもの。現時点ではオーディオトラックのみで、MIDI機能はないそうですが、あまり音楽制作のスキル、知識がない人でも、曲作りができるような工夫が随所になされているようです。

そのSoundmainが先日Flow Machinesとコラボする形でユニークな実証実験が行われたということで、そのデモが披露されたのです。そう、Flow Machinesで生成したメロディに歌詞をつけたうえで、AI歌声合成を使ってボーカルトラックを作り、それを音楽素材データと組み合わせて楽曲を作っていくという試みです。

ブラウザ上で動作するDAWであるSoundmain Studio上で、Flow Machinesで作曲したボーカルを使って曲を組み立てていく

ブラウザ上で動作するDAWであるSoundmain Studio上で、Flow Machinesで作曲したボーカルを使って曲を組み立てていく

もともと2小節分64の歌詞をFlow Machinesが作り出したメロディーで歌わせたものを、適当に並べていたのですが、さすがにそのままだと、意味もよくわからないので、ある程度意味が通る形に並び替えるとともに、メロディの並びをある程度調整することにより、結構しっかりした曲になるのです。どこまで印象に残るメロディなのか……といわれると、微妙な部分はあるけれど、これがなんとなく背景に流れていたら、それがAIが作曲し、AIが歌っているものとはまったく気づかないのでは……というものになってきているのです。

こんなものを目の当たりにすると、将来、すべてAIが作った楽曲がヒット曲になっているのでは……ということを夢想してしまいますが、これについて菊地さんは「今回、いろいろな実験をしてみて、改めて人間は音楽を作る際に、すごいいっぱいのことを、さらっと普通にやっているんだな…ということを感じました。これを全部コンピュータにやらせるのは、当面不可能だと思います。AIが考えているのではなく、AIができるように仕組みを作ってやらせているわけで、今回そのごく一部をやらせてみたのに過ぎないんです」と話します。その話を聞くと、ちょっと安心するような、ちょっとガッカリするような……複雑な思いもありますが、一歩一歩未来に向かってはいるようです。

数多くある音楽制作過程の中で作曲部分の一部をFlow Mashinesが担当する形

数多くある音楽制作過程の中で作曲部分の一部をFlow Mashinesが担当する形

でも、どうなっていくことを目指しているのか、AIは音楽制作にどのように関わってくるようになるのでしょうか?「クリエイターにとって、負担を減らすための便利なツールにはなっていくのではないでしょうか?たとえばメロディを作っていく仕事において、バックトラックづくりは本質ではありません。テンポとジャンル、コード進行を選んだら、簡単なバックトラックができ、あとはそれにマッチしたメロディを作っていくだけ…となったら、人はその本質に集中することができるでしょう。そんな風にAIを利用できるようになるといいのではないでしょうか」と菊地さん

「その逆のケースもあると思います。メロディーはともかく、カッコいいバックトラックを作りたいという場合、そこそこのものを作り出してくれれば効率的だし、それに合わせて歌ってくれたりすればますますいいと思います。ビデオ用のBGMなんかは、そうした作り方がマッチしそうですね」と後閑さん。

今回のパネルディスカッションでの話を聞くと、まだまだ発展途上ではあるけれど、AIを使った音楽制作、どんどん熱くなっていきそうです。

そうした中、オープンハウス2022に参加した方からは、リアルタイムに質問が寄せられたので、いくつかピックアップしながらパネラーに答えてもらいました。その一部を紹介してみましょう。

まさに今話題のNFTですが、その前に、そもそもAIが作曲した作品の著作権が誰にあるのか、というところが気になります。この点については後閑さんに伺ってみました。

続いては次のような質問です。

確かに、既存の楽曲を学習させて、それっぽい曲を作り出せるとしたらとても便利そうではありますが、ちょっと危険な気もします。これについては菊地さんに答えていただきました。

といった具合で、いろいろ興味深い質疑応答が行われました。約50分のパネルディスカッションではありますが、現在も視聴することが可能なので、当日見逃した方、見たけどもう一度じっくり見てみたい方など、ぜひご覧になってみてはいかがでしょうか?

【YoTubeアーカイブ】

【関連情報】

Flow Machines情報

Soundmainサイト

ソニーCSL オープンハウス2022

【ダウンロード】

◎App Store ⇒ Flow Machines

コメント