一般的にコンピュータを使った音楽制作といえば、DAWを使い、ソフトウェア音源やエフェクトのプラグインを使って……という世界を思い浮かべると思いますし、多くの人はそうした音楽制作を行っていると思います。しかし、それとはまったく違うサウンドプログラミングという音楽制作の世界があるのをご存じでしょうか?Max/MSPやPure Data、SuperCollider、Tidal Cycles、ChucK、OverTone……といったツールを用い、プログラミングという手法で音楽を作っていく世界です。

そんな音楽制作の世界を紹介する書籍「音楽制作~プログラミング・数理・アート」というものが、コロナ社から出版されました。これまで、Max/MSPの入門書やPure Dataの入門書など、各ツールを紹介する書籍というものは存在していましたが、こうした世界を系統的にまとめた書籍が存在していなかったことから、新たに出版したとのこと。先日、その本の編著者であり、元セガ・エンタープライゼスのサウンドデザイナーで、現在は東京工科大学の教授である松村誠一郎先生にお話しを伺うことができたので、サウンドプログラミングを用いた音楽制作とはどんな世界なのか、インタビューしてみました。

サウンドプログラミングを用いた音楽制作とはどんな世界なのか… (画像はAIで生成したイメージです)

新著、「音楽制作~プログラミング・数理・アート」とは

松村先生には、先日「音の世界を深く探る新刊『サウンドデザイン』。ゲームからメディアアートや建築まで広がる音の可能性とは?」という記事でインタビューさせていただいていました。そのときは「サウンドデザイン」という本をテーマにインタビューしていたのですが、同じコロナ社のメディアテクノロジーシリーズとして、今回は「音楽制作~プログラミング・数理・アート」というという本を出版されています。以下がその本の目次です。

「音楽制作~プログラミング・数理・アート」目次

第1章 電子音楽の制作ツール

1.1 電子楽器の登場

1.1.1 民生機のアナログシンセサイザ

1.1.2 民生機のデジタルシンセサイザ

1.2 シンセサイザの原理

1.3 DSPによる電子楽器

1.3.1 初期のDSP開発

1.3.2 ウェーブテーブルからPCMへ

1.3.3 デジタルシンセサイザの音源方式

1.3.4 ソフトウェアシンセサイザ

1.4 シーケンサ

1.4.1 シーケンサの芽生え

1.4.2 アナログシーケンサ(CV/GATE)

1.4.3 CV/GATEのデジタルシーケンサ

1.4.4 MIDIシーケンサの特徴

1.4.5 ハードウェアシーケンサ

1.4.6 ソフトウェアシーケンサ

1.4.7 リアルタイムレコーディングとステップレコーディング

1.4.8 MIDIイベントと分解能

1.4.9 MIDIトラックとオーディオトラック

1.4.10 プラグイン(インストルメント,エフェクト)

1.5 ミュージックトラッカー

1.5.1 トラッカーとは

1.5.2 サンプラーとシーケンサの組合せ

1.5.3 初期のトラッカー

1.5.4 現在のトラッカー

1.5.5 音楽教育ツールとしてのトラッカー

1.6 サウンドプログラミング

1.6.1 Pure Data

1.6.2 Pure Dataのプログラミング方法

1.6.3 MIDIの制御とDSPの制御

1.6.4 メッセージデータとDSPデータの境界

1.6.5 インタフェースの変化と固定化

1.6.6 BSDライセンスとPure Dataコミュニティ

1.6.7 Pure Dataのパッケージ

1.6.8 Dekenによるライブラリ追加

1.6.9 シーケンサの時間軸とインタラクションの時間軸

1.6.10 Pure Dataの作品事例

1.7 まとめ

第2章 ライブコンピュータ・エレクトロニクス

2.1 ライブコンピュータ・エレクトロニクスとはなにか

2.2 ライブコンピュータ・エレクトロニクスの誕生

2.2.1 ピエール・ブーレーズ

2.2.2 ブーレーズと電子音楽

2.2.3 IRCAMの設立と4Xの開発

2.2.4 『レポン』:ライブコンピュータ・エレクトロニクスの原点

2.2.5 デジタル信号処理による音の変形

2.2.6 楽器と電子音響の演繹的拡張と統一

2.2.7 『レポン』の空間性

2.2.8 託された課題

2.3 プログラミング環境 Max

2.3.1 Max とはなにか

2.3.2 Max 開発の背景

2.3.3 Max の登場

2.3.4 Max の実用化

2.3.5 Max の展開

2.3.6 Max の特徴

2.4 ライブコンピュータ・エレクトロニクスの実践

2.4.1 新しいミュジシャンコンプレ

2.4.2 ピアノとコンピュータのための音楽

2.4.3 上演プロセス:準備

2.4.4 上演プロセス:演奏

2.5 ライブコンピュータ・エレクトロニクスの現在

2.5.1 オペラの舞台に立つアンドロイド

2.5.2 歌唱システム

2.5.3 動きのシステム

2.6 まとめ

2.6.1 インタラクションとはなにか

2.6.2 ライブコンピュータ・エレクトロニクスの課題

2.6.3 ライブコンピュータ・エレクトロニクスの持続可能性

第3章 音響コンポジション

3.1 音と作曲

3.1.1 音「の」作曲

3.1.2 音のプログラミング

3.1.3 音と響き

3.1.4 音の存在論と作曲

3.2 SuperColliderの特徴

3.2.1 構成

3.2.2 実践

3.3 関連作品やプロジェクト

3.3.1 WFS

3.3.2 BEAST

3.3.3 『AudioScape』

3.3.4 norns

3.3.5 『breathing space』

3.3.6 空港のための音楽

3.3.7 AI×Beethoven

3.3.8 可聴化研究

3.3.9 『snr』

3.3.10 『spray』

3.3.11 『matrix』

3.3.12 『x/y』

3.3.13 『textures±』

3.4 まとめ

第4章 ライブコーディング

4.1 ライブコーディングとは

4.1.1 ライブコーディングの定義

4.1.2 プログラミング言語のライブ性

4.1.3 コンパイラとインタープリタ

4.1.4 プログラミング言語におけるライブコーディングの歴史

4.1.5 ライブパフォーマンスとしてのライブコーディング

4.1.6 ライブコーディングの世界への広がりとコミュニティ

4.1.7 Show us your screen(スクリーンを見せろ)

4.2 ライブコーディングのための主要なプログラミング言語

4.2.1 Max

4.2.2 Pure Data

4.2.3 SuperCollider

4.2.4 ChucK

4.2.5 OverTone

4.2.6 TidalCycles

4.2.7 Extempore

4.2.8 Gibber

4.2.9 Sonic Pi

4.2.10 FoxDot

4.2.11 Orca

4.2.12 Strudel

4.2.13 その他の環境

4.2.14 ライブコーディングによるパフォーマンス事例

4.3 TidalCyclesによるライブコーディング実践

4.3.1 TidalCyclesを構成するプログラミング言語,ライブラリ,アプリケーション

4.3.2 Windows,macOSへの手動インストール手順

4.3.3 TidalCyclesの起動と終了

4.3.4 TidalCyclesによるパターンの生成の基本

4.3.5 パターンを変化させる

4.3.6 シンセサイザを使う

4.3.7 ライブコーディングパフォーマンス実践

4.4 まとめ

第5章 作曲技法と数理

5.1 音楽と数学の歴史

5.2 ピッチクラス集合論

5.2.1 音高の同値類とその集合

5.2.2 教会旋法とダイアトニック集合

5.2.3 集合,部分集合,補集合

5.2.4 集合間の写像

5.2.5 共通音定理

5.3 ブーレーズのブロックソノール技法の数理

5.3.1 ブロックソノール

5.3.2 ブロックソノールの積の演算

5.3.3 ブロックソノールの代数学

5.3.4 ブロックソノールの組合せ論

5.4 作曲上の意思決定の数理

5.4.1 制約充足問題と制約最適化問題

5.4.2 ブロックソノールを用いた作曲への制約プログラミングの応用

5.4.3 ハーモニックドメインの割り当てによる大域構造の決定

5.4.4 ハーモニックドメイン内のブロックソノールの経路の決定

5.5 まとめ

第6章 メディアアートとミュージックテクノロジー

6.1 メディアアートとミュージックテクノロジーの関係

6.2 バーチャルミュージカルインストルメントとロボット工学の芸術的アプローチ

6.2.1 ロボットのインテリジェンス

6.2.2 バーチャルミュージカルインストルメントと『RoboticMusic』の開発

6.2.3 作品への応用と新たなメディアアート技術の適用

6.2.4 ロボティクスの展望

6.3 バーチャルミュージカルインストルメントの技術的側面と実装

6.3.1 ジェスチャーと音楽

6.3.2 マッピングインタフェース,アルゴリズム,サウンドシンセシス,映像

6.3.3 サウンドシンセシス,サウンドとジェスチャーによる音楽制作

6.3.4 音楽のコンテクストとインタラクションの課題

6.3.5 パフォーマンスの問題点:人間の知覚とコンピュータの限界

6.4 バーチャルミュージカルインストルメントを用いた作品例(初期の作品)

6.4.1 『L’homme transcendé』

6.4.2 『netBody』

6.5 バーチャルミュージカルインストルメントを用いた作品例(メディアアートとの関連作品)

6.5.1 『Cymatics』

6.5.2 『Hypnoïde』

6.5.3 『Body in Zero G』

6.5.4 『gravityZero』

6.6 まとめ

引用・参考文献

索引

「第1章のシンセサイザやシーケンサだけはなんとなく分かったけど、それ以降が何のことやらさっぱり分からない……」という人も少なくないと思います。とはいえ、実際に触ってみると、どっぷりとハマってしまう人も多そうなので、いろいろと伺っていきましょう。

長い歴史を持つ、プログラミングで音楽を作る世界

--「音楽制作」という書籍タイトルを見て、DAWやプラグインの世界の話かと思ってページを開いたらまったく違う世界の内容だったので、ちょっと驚きました。

松村:いわゆるDTMの世界ではなく、音楽情報処理とも違う、創作系の電子音響音楽をやっている人たちというのが世界中に数多くいます。MaxやPure Data、SuperColliderといったものが標準言語として使われている世界で、グラニュラーなどの音響合成や独自のエフェクトの開発、アルゴリズム作曲などによる実験的な音楽制作を行なったり、最近ではマルチチャンネルをどう処理するか、立体音響をどう制作するか……といった話題で盛り上がっています。その流れを紐解くと、非常に長い歴史があるのです。私自身はDTMによる音楽制作の世界も見つつ、そうしたサウンドプログラミングによる音楽・音響制作の世界にも身を置いてきました。気が付くと、両者を橋渡ししたり、こうした世界について横断的にまとめて紹介した書籍というのがありませんでした。それならばと、5人の方にお声がけして執筆に参加してもらい、書籍としてまとめたのが「音楽制作~プログラミング・数理・アート」という本なのです。

サウンドプログラミングに関する情報をまとめたコロナ社の書籍「音楽制作~プログラミング・数理・アート」

--長い歴史とのことですが、その源流はどのあたりになるのでしょうか?

松村:私が執筆している第1章や今井慎太郎さんが担当した第2章で、簡単な歴史などを紹介していますが、1957年にアメリカのベル研究所でDSPの研究が開始されたのが始まりとされています。このときベル研究所にあったIBMの大型コンピュータを使ってどうやって音を作り出すかという研究が行われていました。

--当時はすでにアナログシンセサイザは存在していたころですよね。

松村:はい、ほぼ同じ時期にいわゆるアナログのモジュラーシンセが登場していましたが、その各モジュールに相当するものをどうやってコンピュータでのDSP(デジタル信号処理)で実現させるか、ということが考えられたのです。この際、マックス・マシューズ(Max Mathews)という人がユニットジェネレータという概念を生み出しました。これはソフトウェア上の信号処理モジュール、つまり1つの単位となるもので、それらを仮想的に接続して処理を行なう研究が始まったのです。ちなみにSuperColliderというサウンドプログラミング環境の中にもユニットジェネレータというものがありますが、これはまさに当時の概念が現在まで引き継がれたものと言えます。

インタビューした東京工科大学・教授の松村誠一郎先生

60年以上前に作られたユニットジェネレータという概念

--ここでいうDSPというのは、今のDSPというプロセッサという意味ではなくて、コンピュータを使った信号処理のプログラミングという理解で合ってますか?

松村:その通りです。マシューズはその1957年にMusic Iという音響合成用のプログラムを開発し、三角波を鳴らすデータを生成しています。ピッチと音長を指定することができ、D/Aコンバータ(デジタル/アナログ変換器)を経由してスピーカーから音の旋律を鳴らすことに成功しました。続く1958年にはMusic IIを、さらに1960年にMusic IIIを開発し、ユニットジェネレータの概念を具現化させていったのです。この辺は産総研の後藤真孝さんたちが翻訳をしたカーティス・ローズ(Curtis Roads)の著書「コンピュータ音楽~歴史・テクノロジー・アート」(東京電機大学出版局)に詳しくあるので参考にしてみるといいかもしれません。

--60年以上前から、そんな研究が行われていたのですね。

松村:マシューズのユニットジェネレータという概念を発展していくために、さまざまな人が引き継いで、Music IV、V、VI……と開発を続けていったのです。そうした中で、MITのバリー・ベルコー(Barry Vercoe)によって開発されたMusic 11から、CsoundというC言語をベースにしたプログラミング言語でサウンドプログラミングを行うことができるパッケージが生まれています。これは現在も開発が続いています。さらにはMITのベルコーの研究室に在籍していたミラー・パケット(Miller Puckette)によって1982年に作られたMusic400と続く1985年のMusic 500が、後のビジュアルサウンドプログラミング環境のMaxのスタートとなっています。Csoundなど従来の環境ではプログラミングができないと音を出すことができないわけで、特に音楽制作者や音楽家にとっては非常にハードルの高いものでした。そうした技術者でなくても、GUIでオブジェクト同士を線でつないでプログラミングができ、簡単に音を出すことができるように開発されたのがMaxです。音の世界において、このようなGUIのプログラミング環境を実現したのはMaxが最初ですね。そのMaxについては、この書籍の第2章で今井慎太郎さんが、詳しく書いています。もちろん、このMaxという名前は、源にあるマックス・マシューズに敬意を表して名付けたものですね。

--なるほどMax/MSPのMaxは、ベル研究所にいた研究者の名前だったんですね。なんとなく、その流れというのはわかったのですが、そうしたツールを使って、何をするわけですか?

松村:一般的にはDAWなどを使って音楽を作るというのがもちろん主流ではあると思います。でもそのベースには楽器が弾けなくてはならない、作曲理論を学ばなくてはならない……といったハードルがあるのも事実です。そこにテクノロジーやプログラミングを用いることによって、そのハードルが低くなるという面もあります。また、DAWでは実現が難しい、音についての実験的な試みや細かい音響の操作を、独自のシステムを作って実践することがサウンドプログラミングでは可能です。やりたいことは音楽制作ではあるけれど、その手段が多様化しており、こうしたサウンドプログラミングを用いた音楽制作が一つの潮流になっているのです。ハードウェアでは、それに近いものがアナログモジュラーシンセサイザーの世界ではないでしょうか?

サウンドプログラミングとアナログモジュラーシンセの対比

--アナログモジュラーシンセサイザーの世界が近いというのは、どういう面ででしょうか?

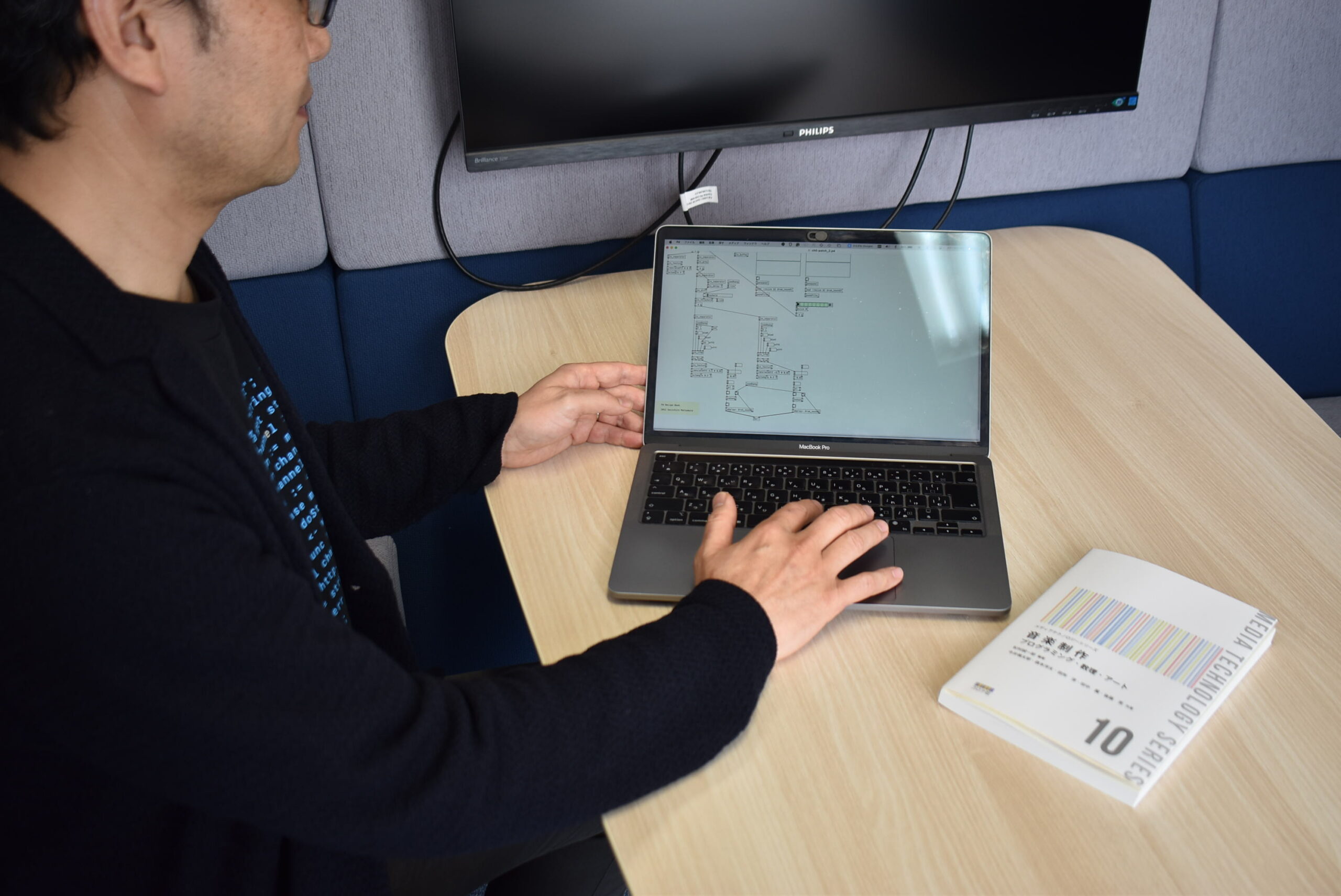

松村:モジュラーシンセの世界は先ほども触れたとおり、長い歴史がありますが、コロナ禍に入る前くらいにリバイバルブームになってきていて、現在も非常に盛り上がっています。ここではピアノが弾けるとか、ギターが弾ける……というのではなく、シーケンサやアナログシンセ、モジュラーシンセを操りながら、パラメータの調整によって音楽を表現しライブパフォーマンスを行なう方法がポピュラーになってきました。それに近い感じでサウンドプログラミングを使って音楽を表現していくわけです。実際、観客の前で即興的にプログラミングして音楽を作るライブパフォーマンスである、「ライブコーディング」というものもあり、本書でも第4章で詳しく取り上げています。もっともサウンドプログラミングを使った表現の仕方は100人いれば100通りあり、みんな違うと思います。実際、この本を執筆した6人の著者間でも考え方は多様で、たとえば本書のタイトル案を決める際も、その違いから活発な議論になりました。

ーーでは、流行っているモジュラーシンセの世界と比較した際、このサウンドプログラミングの良さというと、どんなことになるのでしょうか?

松村:たとえばグラニュラーシンセシスを用いて音楽を作ろうとした場合、従来であればグラニュラーシンセシスに対応したハードウェアシンセを買うか、プラグインを使うしかありません。しかし、サウンドプログラミングを使えば、すべて自分で設計して組み立てて音をだすことができるのが醍醐味です。また、世の中には数多くのサンプルプログラムがあるので、それを利用して改良しつつ、実際にグラニュラーがどういう原理で動いているのか、どうやってシンセを鳴らしているのか、つぶさにその動きを見て原理原則を学ぶことができます。そこがサウンドプログラミングのいいところであり楽しいところです。もちろんモジュラーシンセやプラグインでもある程度理解できるとは思いますが、かなりのお金が必要になります。それに対し、サウンドプログラミングなら、無料か、お金を払っても5万円程度で済むというのもメリットだと思います。

--SunoやUdioといったAI音楽生成の世界とはまたずいぶんと方向性の異なるものですね。

松村:現在はAIが発達して、プロンプトを入力して音楽ができてしまう世の中になってきています。今後、どうしてこの音楽が生成されたのか、その中身をまったくわからないままだけれど、それを当たり前とする世代が増えてくるのでしょう。それは便利で、1つの流れなんだとは思います。でもAIが進化したとしても、人間が作る音楽がなくなるわけではありませんし、自分はゼロから作るという音楽制作者の層は一定数は存在していくと思います。一方で、AIは構造的に、学習してきたデータの平均値的なもの、多くの人達にとってストライクゾーンに入るものを出力してきます。すごく突飛なものや従来の考え方では音楽として成立しないようなものなどは範疇外となってしまいます。しかし、その範疇外の表現を人間が実験的に作っていくことで、新しい方向性が出てくると思いますし、光を見せていくことにつながっていくでしょう。平均値で満足するのではなく、そこから外れたものを開拓していく、それをサウンドプログラミングの世界でチャレンジしていく、というのも面白いのではないでしょうか?

--個人的にも非常に興味があったものの、ちょっと怖くて触れてこなかったというのが実際のところなので、まずはこの本を読みつつ、ちょっとチャレンジしてみようと思います。ありがとうございました。

【関連情報】

コロナ社 メディアテクノロジーシリーズ

【価格チェック&購入】

◎Amazon ⇒ メディアテクノロジーシリーズ10 音楽制作 プログラミング・数理・アート

◎コロナ社 ⇒ メディアテクノロジーシリーズ10 音楽制作 プログラミング・数理・アート

コメント