毎年恒例のAvidのイベント、Avid Creative Summit 2024が2月9日に開催されました。今回は”未来をつなぐIP、イマーシブにより拡張される音で共感する”をテーマに行われたのですが、非常にユニークだったのは東京と大阪の2拠点同時開催で、それぞれがネットワーク接続された上で、リアルタイムに相互やりとりをしながらセミナーが行われたという点。ちょうどPro Toolsの最新バージョン、Pro Tools 2023.12にDolby Atmos Rendererが搭載されて間もないタイミングだったこともあり、注目を集めていたイベントでしたが、東京・大阪それぞれの会場にかなり多くの人が集まってのリアル開催となりました。

今回、私は大阪側の会場に参加したのですが、ふと「ここは東京か!?」と錯覚するような不思議なイベントでもありました。セミナーでは最新のPro Toolsに搭載された機能に関する説明があったほか、Flux:: Spat Revolutionに関するプレゼンテーション、Cygamesの新作「GRANBLUE FANTASY: Relink」のサウンドづくりに関する紹介、日本音楽スタジオ協会長でありサウンドプロデューサー、エンジニアであるミキサーズラボの高田英男さんによる360 Reality Audioでの音作りの紹介など非常に充実した内容になっていました。その一方で、どうやって東京・大阪をリアルタイム接続してこのイベントを実施しているのかという裏舞台に関する紹介があったのも興味深いところでした。そのAvid Creative Summit 2024の内容をかいつまんで紹介してみたいと思います。

2024年2月9日、東京と大阪でAvid Creative Summit 2024が開催された

2024年2月9日、東京と大阪でAvid Creative Summit 2024が開催された

東京と大阪をオンライン接続して開催されたAvid Creative Summit 2024

このAvid Creative Summit 2024については先日「2月9日 東京・大阪で初の同時開催!最新の音楽制作を知れるAvid Creative Summit 2024。来場者には豪華プレゼントも」という記事で取り上げたところ、東京会場、大阪会場ともにすぐに満席となり、当日は両会場で合わせて172名が参加する形で開催されました。

Avid Creative Summit 2024会場には協賛各社のブースも設置されていた

Avid Creative Summit 2024会場には協賛各社のブースも設置されていた

両会場をネットワークで接続する形で東京、大阪の交互で行われるセミナーを中心に、協賛企業による展示も行われる形になっていました。私の行った大阪会場ではメイン会場の座席後方にメディア・インテグレーション輸入事業部、オタリテック、アビッドテクノロジーの各社がブースを出して展示を行っていたほか、Focal Professionalのモニタースピーカー、ALPHA EVOを用いた360 Reality Audioの体験ゾーンも設置。

一方隣の部屋にはTOAが同社のスピーカー、ME-50FSを使い、限りなくリアルな原音忠実サウンドを実現するデモを行っていました。スピーカーとともにアイソレート・バランス給電という独特な手法を用いた環境により、スピーカーでなっている音なのか、手で鳴らしている鈴の音なのかを比較するテストを行っていたのですが、あまりにもリアルでどちらか私には判別できず…。そのリアルさに来場したみなさんも驚いていたようでした。

TOAのME-50FSのリアリティーさを実証するデモンストレーション

TOAのME-50FSのリアリティーさを実証するデモンストレーション

Pro ToolsにDolby Atmos Rendererが搭載に

では、ここからセミナーの内容を簡単に紹介していきましょう。まず最初に行われたのは東京会場においてAvid TechnologyのDaniel Lovellさんによる「What’s New Avid Product 2024〜Pro Tools 最新情報のすべて〜 」。

Pro Tools 2023.12に実装されたDolby Atmos Renderer

Pro Tools 2023.12に実装されたDolby Atmos Renderer

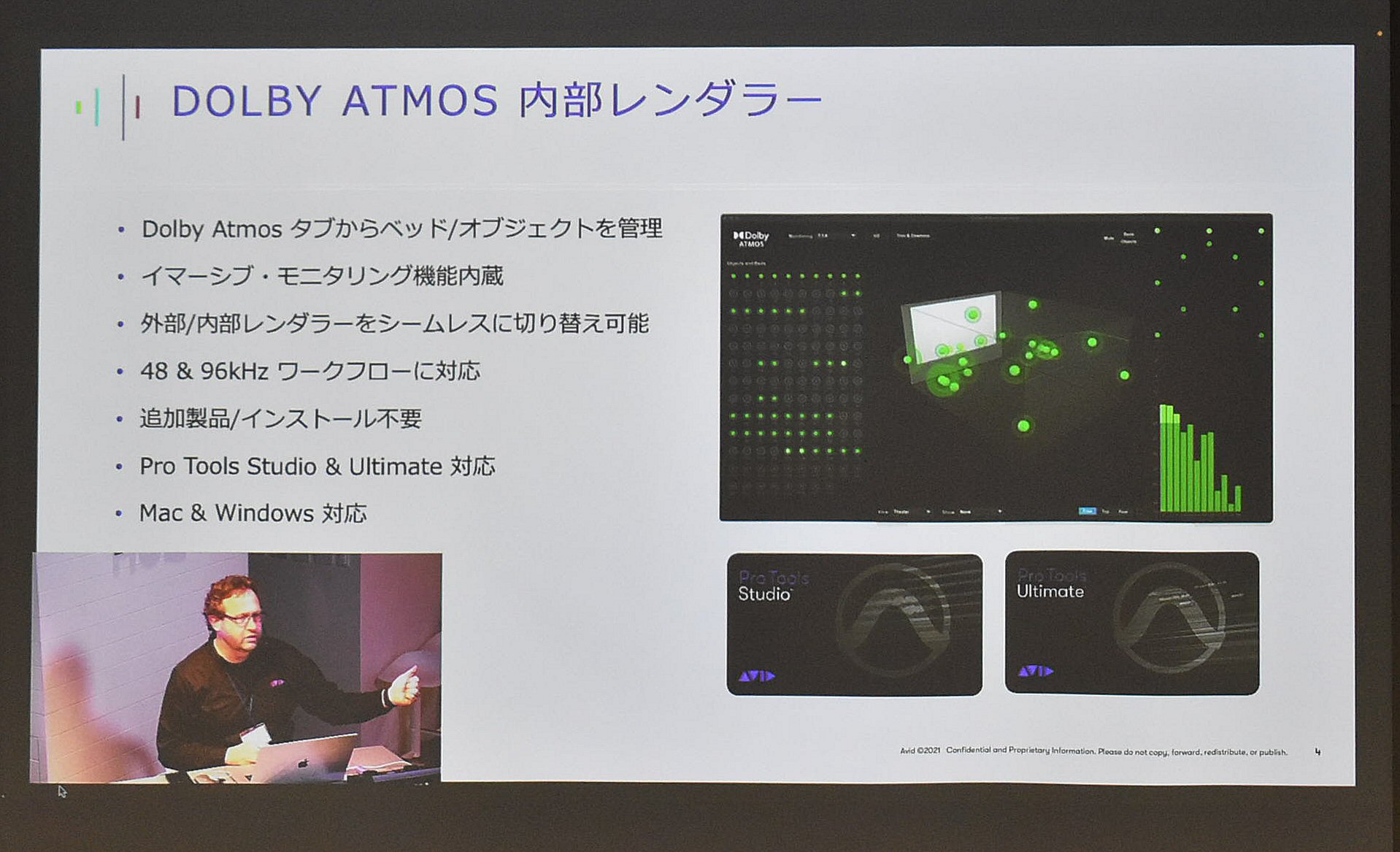

ここでは、まずPro Tools 2023.12で実装されたDolby Atmos Rendererについての解説がありました。今回Pro Tools StudioおよびPro Tools Ultimate自体に実装されたため、オプション不要でDolby Atmos作品が作れるようになったのが大きな目玉。Dolby Atmosタブからベッド、オブジェクトのそれぞれを管理できるようになっているとともに、イマーシブ・モニタリング機能も内蔵し、内部と外部のレンダラーをシームレスに切り替え可能になっています。このイマーシブモニタリングではヘッドホンを使って2.0から Pro Tools Studioでは最大7.1.4、 Pro Tools Ultimateでは最大9.1.6までのサウンドをバイノーラルに畳み込んで聴くことができるようになっています。

先日のNAMM Show 2024でPro Toolsにおける新機能がいろいろ発表された

先日のNAMM Show 2024でPro Toolsにおける新機能がいろいろ発表された

そのほか、より多くのマーカー・ルーラーが設定可能となり、各ルーラーを特定用途で使用することが簡単になったこと、バスのグループやそれぞれのバスにおいて色分けが可能になり、設定した色がバス情報の一部として保存可能となったことなども解説。

まもなくPro ToolsにMIDIエフェクト・プラグイン機能が搭載される

まもなくPro ToolsにMIDIエフェクト・プラグイン機能が搭載される

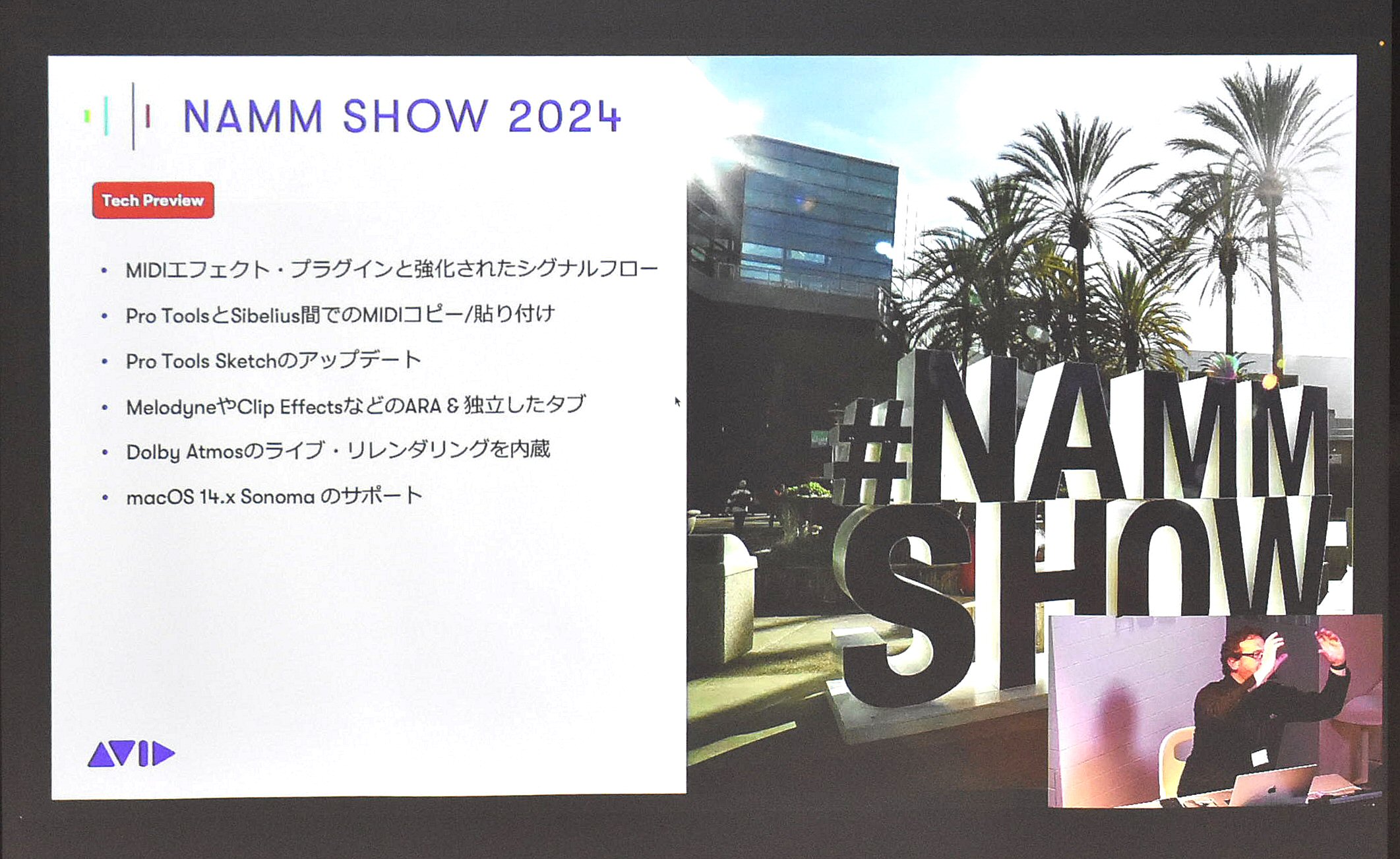

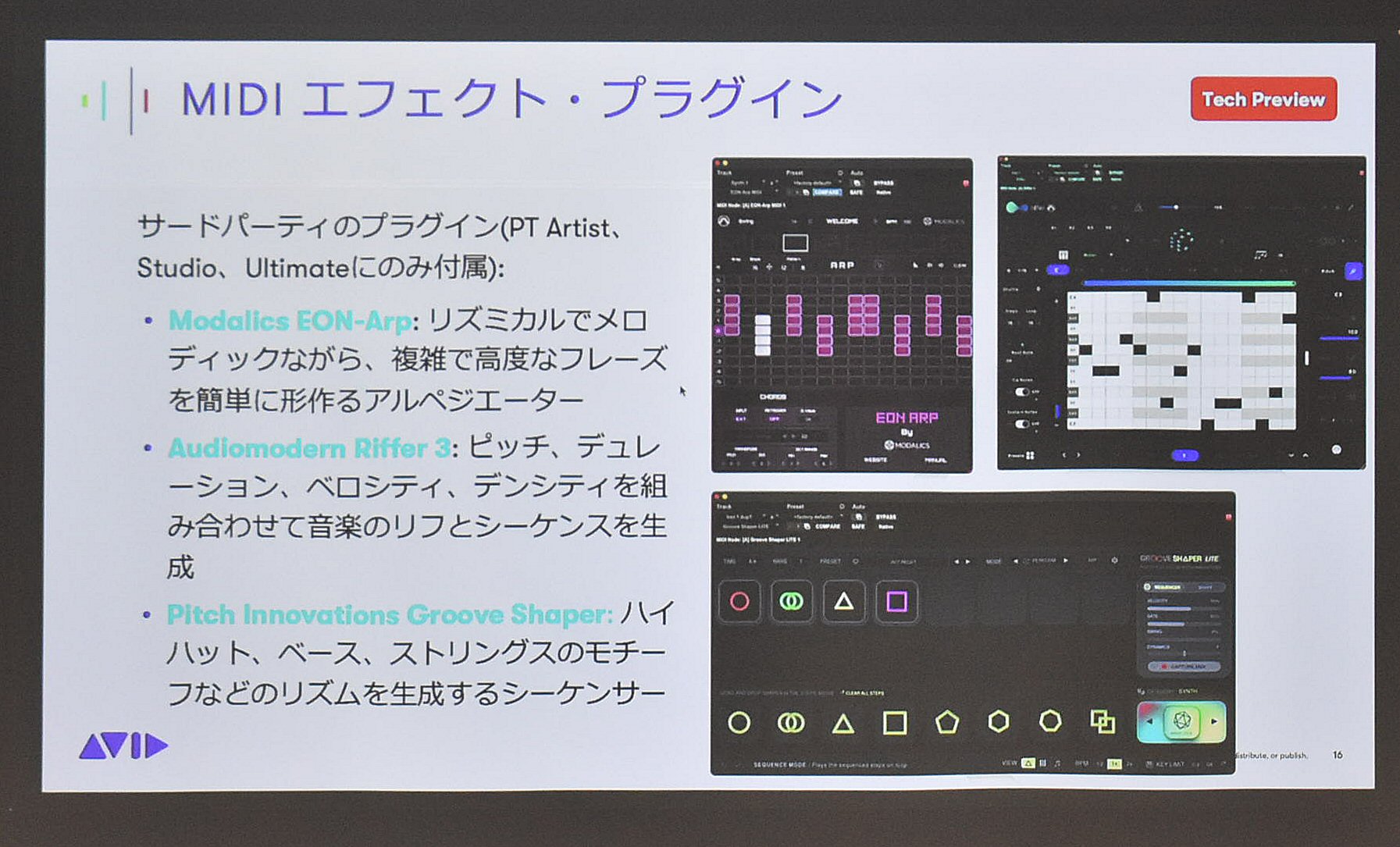

さらに先日のNAMM ShowにおいてPro Toolsの次のアップデートでさまざまな機能が搭載されることが発表されていましたが、その詳細についても紹介されていました。具体的にはMIDIエフェクト・プラグインの実装、ARA2への対応、Dolby Atmos Rendererに関する改善、SibeliusとPro Toolsの相互間でMIDIのコピー&ペーストが可能になり、Sibeliusで楽譜を書いてPro Toolsへ貼り付け、逆にPro Toolsでベロシティやゲートタイム、ExpressionなどのMIDI情報を書いてSibeliusへ戻す、といったフローが可能になることなども紹介されました。

【関連情報】

AVID関連最新情報(AVID公式サイト Resource Center)

Flux:: Spat Revolutionに関する最新情報

続いては大阪会場からの「Flux:: Spat Revolution〜注目の最新情報&Dolby Atmosミックスでの活用例〜 」というセミナー。こちらは、今回初来日だというFlux::のビジネス開発担当シニア・マネージャーHugo Larinさんが解説するものとなっていました。

Flux:: ビジネス開発担当シニア・マネージャー、Hugo Larinさん

Flux:: ビジネス開発担当シニア・マネージャー、Hugo Larinさん

ご存じの方も多いと思いますが、Flux::のSpat RevolutionはIRCAM(フランス国立音響音楽研究所)の技術をベースに開発されたオブジェクトベースのイマーシブ・ミキシング・ツールで、空間にオブジェクトを直感的に配置し、仮想空間の音響特性を想定して目的の深みを作り上げ、ミキシング手法を再定義する、かなり実績のあるツールです。昨年11月にハーマン・プロフェッショナルがFlux::を買収するという発表がされたばかりですが、今回はハーマングループに入ってから初の来日セミナーとなったわけです。

Spat RevolutionのDolby Atmosに関する機能を中心としたプレゼンテーションが行われた

Spat RevolutionのDolby Atmosに関する機能を中心としたプレゼンテーションが行われた

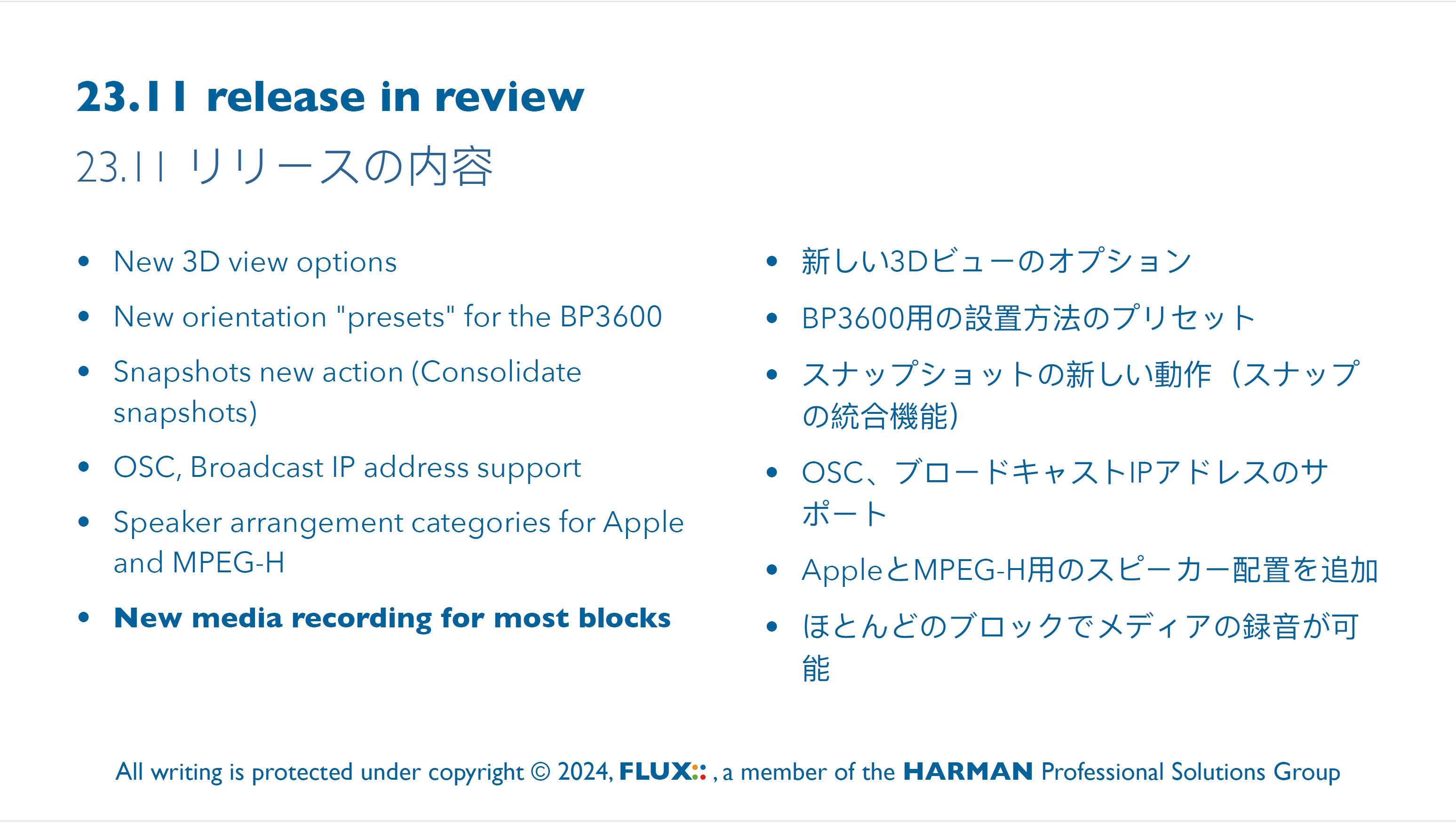

そのSpat Revolutionの最新バージョンが23.11。その前のバージョン23.08のタイミングでApple Siliconにネイティブ対応するとともにVST3フォーマットに対応。またPro Toolsの9.1.6、7次までのAMBISONICSに対応していました。

さらに最新の23.11になったタイミングで、新しい3Dビューのオプションが追加され、BP3600用の設置方法のプリセットも追加、またApple空間オーディオとMPEG-H用のスピーカー配置が追加されている、とのことでした。

その後、再生されたのが英国の有名アーティストの誰もが知っている楽曲。実はこれ、Spat RevolutionでレンダーされたADMのマスターとのこと。そんなマスターを実際に聴けてしまうのも、このイベントの楽しさの一つです。

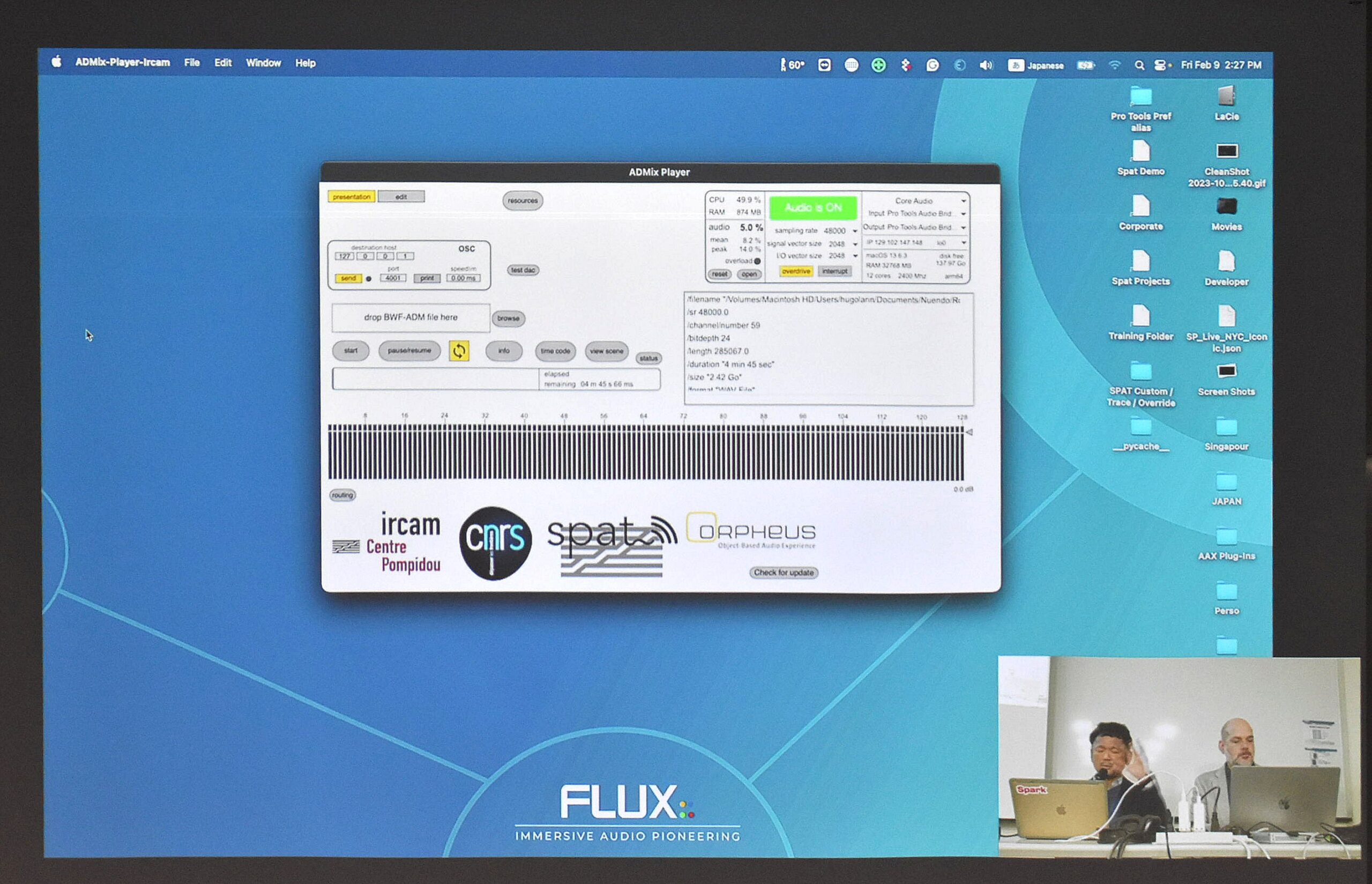

ADMマスターの再生に使われた、Ircam ADMix player

ADMマスターの再生に使われた、Ircam ADMix player

さらにSpat Revolutionを用いてミックス・プリントを作るデモが行われたり、Pro Toolsのセッションを元にSpat Revolutionを使ってのDolby Atmosオーサリングのデモなども行われました。

Spat Revolutionを使ってのDolby Atmosオーサリングのデモの画面

Spat Revolutionを使ってのDolby Atmosオーサリングのデモの画面

【関連情報】

Flux::公式サイト

Flux::国内代理店サイト

Cygames『GRANBLUE FANTASY: Relink』のイマーシブサウンド制作

その後、東京から「生徒のクリエイティビティを最大限に引き出す〜Avid Learning Partner プログラム〜」と題した学生向けのプログラムに関する紹介があったのち、大阪で行われたのがCygamesによるセミナー、「GRANBLUE FANTASY: Relinkにおけるイマーシブサウンド制作 〜素材収録からミキシング、技術進化に伴うイマーシブ制作の変革〜」です。

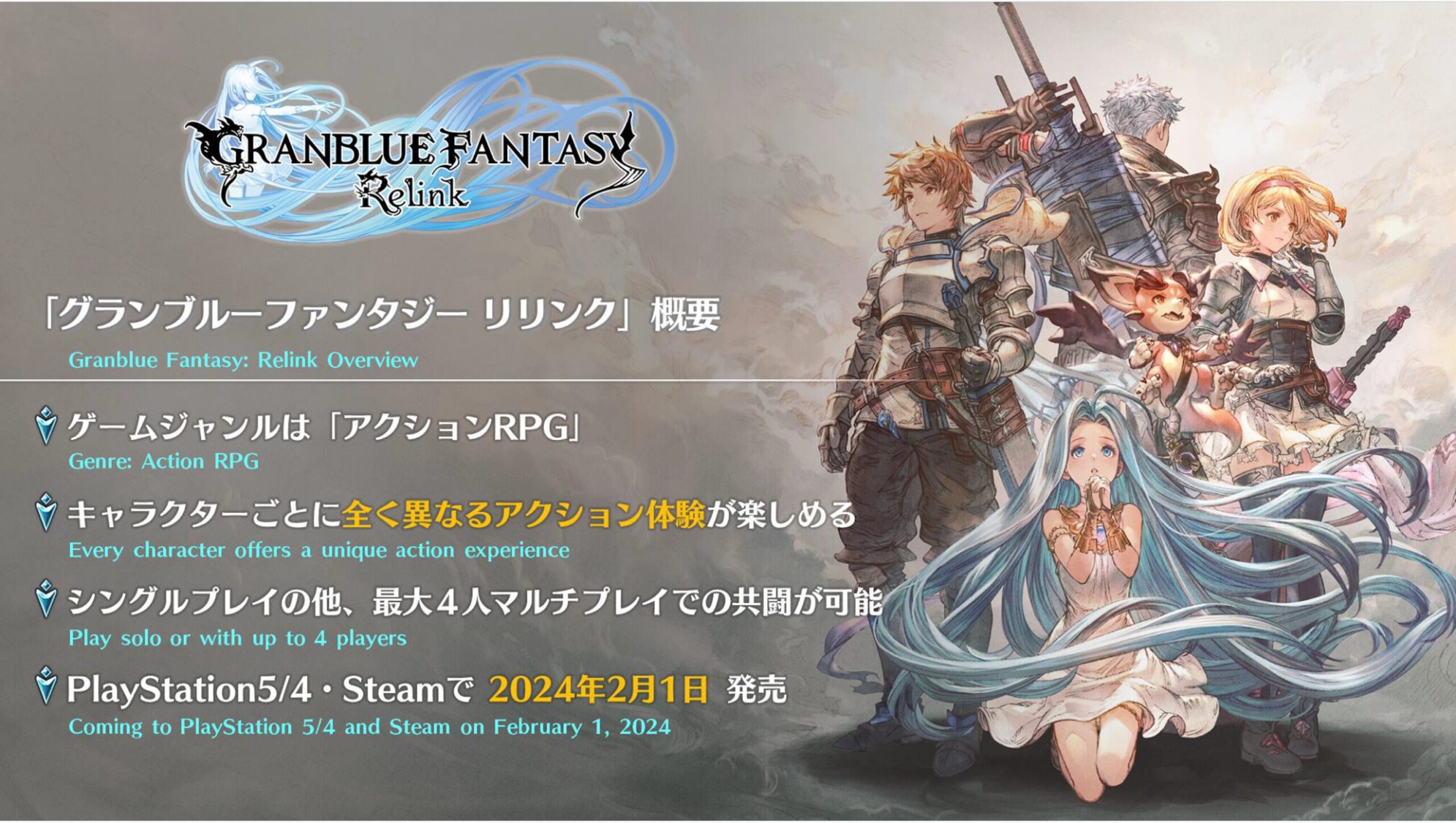

Cygamesは東京や大阪など、それぞれの拠点にスタッフがおり、各地で開発を行っているそうですが、今回はサウンド本部・サウンドデザインチームの大阪在籍メンバーである城後真貴さん、妹尾拓磨さんのお二人が登壇。同社のGRANBLUE FANTASYは2014年3月にリリースされたモバイルRPG。その作品を原作に新たに開発された最新作で、2月1日にPlayStation5/4・Steamでリリースされたばかりの3DアクションRPG、『GRANBLUEFANTASY: Relink』が今回のテーマ。このRelinkの制作において、どのようにしてイマーシブサウンドを実現していったのかの解説が行われていきました。

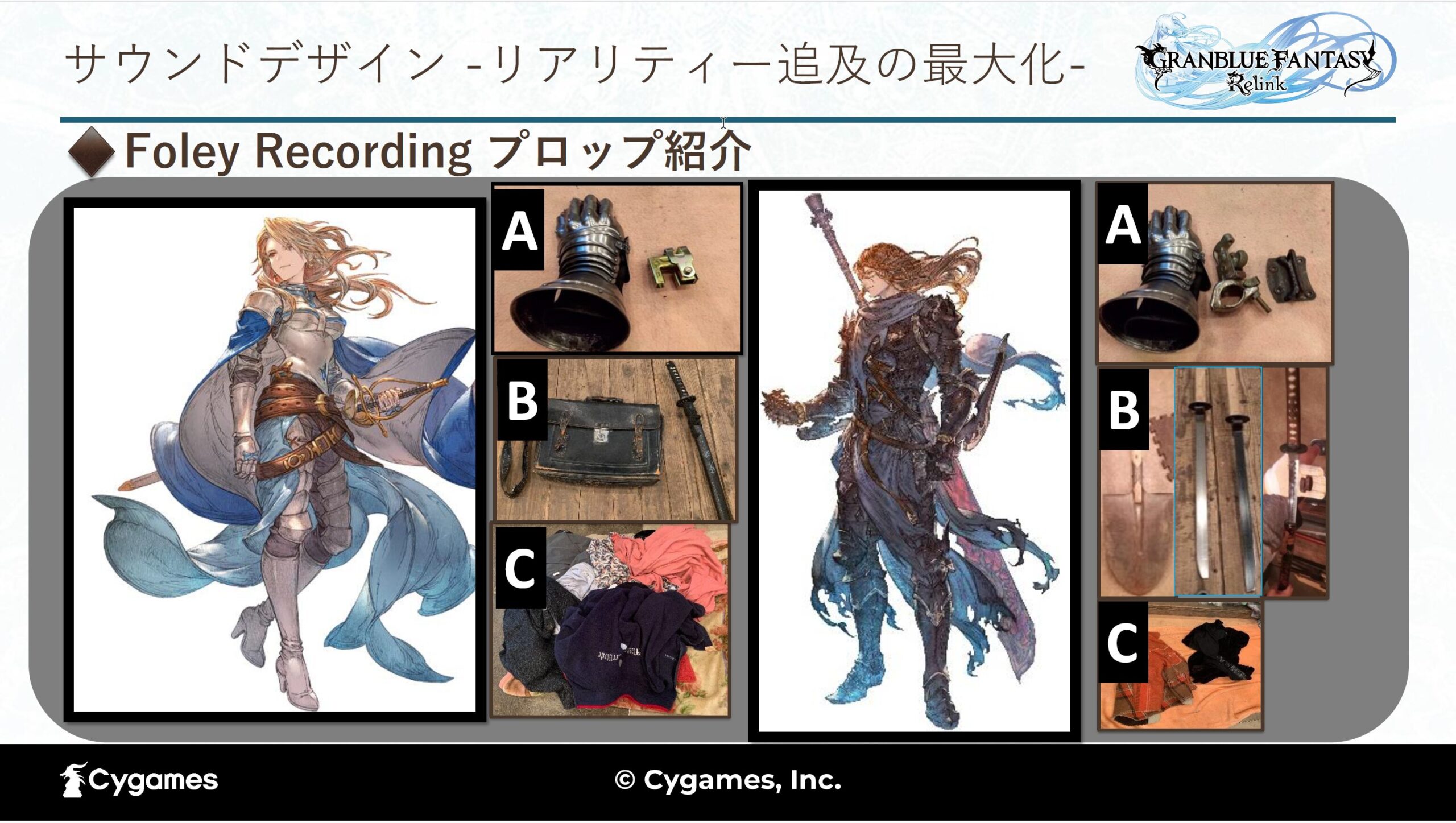

全キャラクタが主役であり、それぞれのキャラクタごとに個性あるサウンドを実現するとともに、アクションによる迫力あるサウンドを実現し、リアリティを出していくにはどうするのか…。

各キャラクタごとに足音も異なるため、それにマッチした音を収録していく

各キャラクタごとに足音も異なるため、それにマッチした音を収録していく

そのためにまずは武器や装飾品の音、足音の質感などをキャラクタごとに実現していくためにフォーリーレコーディングを実施。ここでは入念な準備を行った上で、膨大な数をレコーディング。できる限りリアリティを実現するためにゴムプールを用意して録音したり、草原での足音を実現するのに藁を重ねて揺らしたり、擦り合わせたり。

できる限りリアルな音になるよう、フォーリーレコーディングにはさまざまな工夫が凝らされている

できる限りリアルな音になるよう、フォーリーレコーディングにはさまざまな工夫が凝らされている

また武具をつけての足音はスキーブーツを履いた状態で地面を歩いたり走った音を録ったものの、そもそもスキーブーツはそんな使い方をするものではないから、すぐに壊れてしまうなど、苦労の連続だったのだとか。一方で、環境音はいろいろなところに出向いてフィールドレコーディングしていったそうです。

環境音もリアリティーを追究するため、さまざまなところへ出かけてフィールドレコーディングを行っている

環境音もリアリティーを追究するため、さまざまなところへ出かけてフィールドレコーディングを行っている

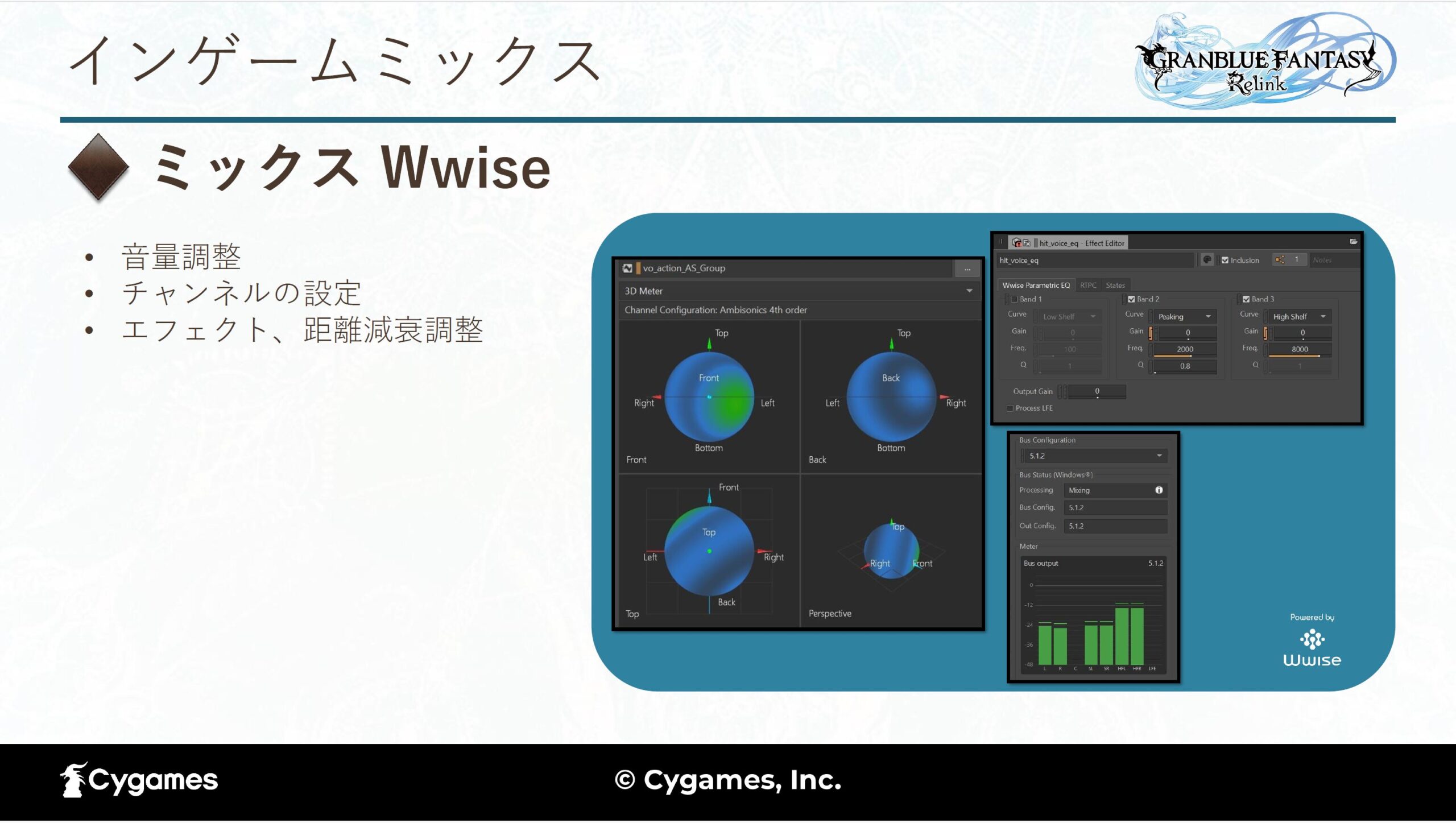

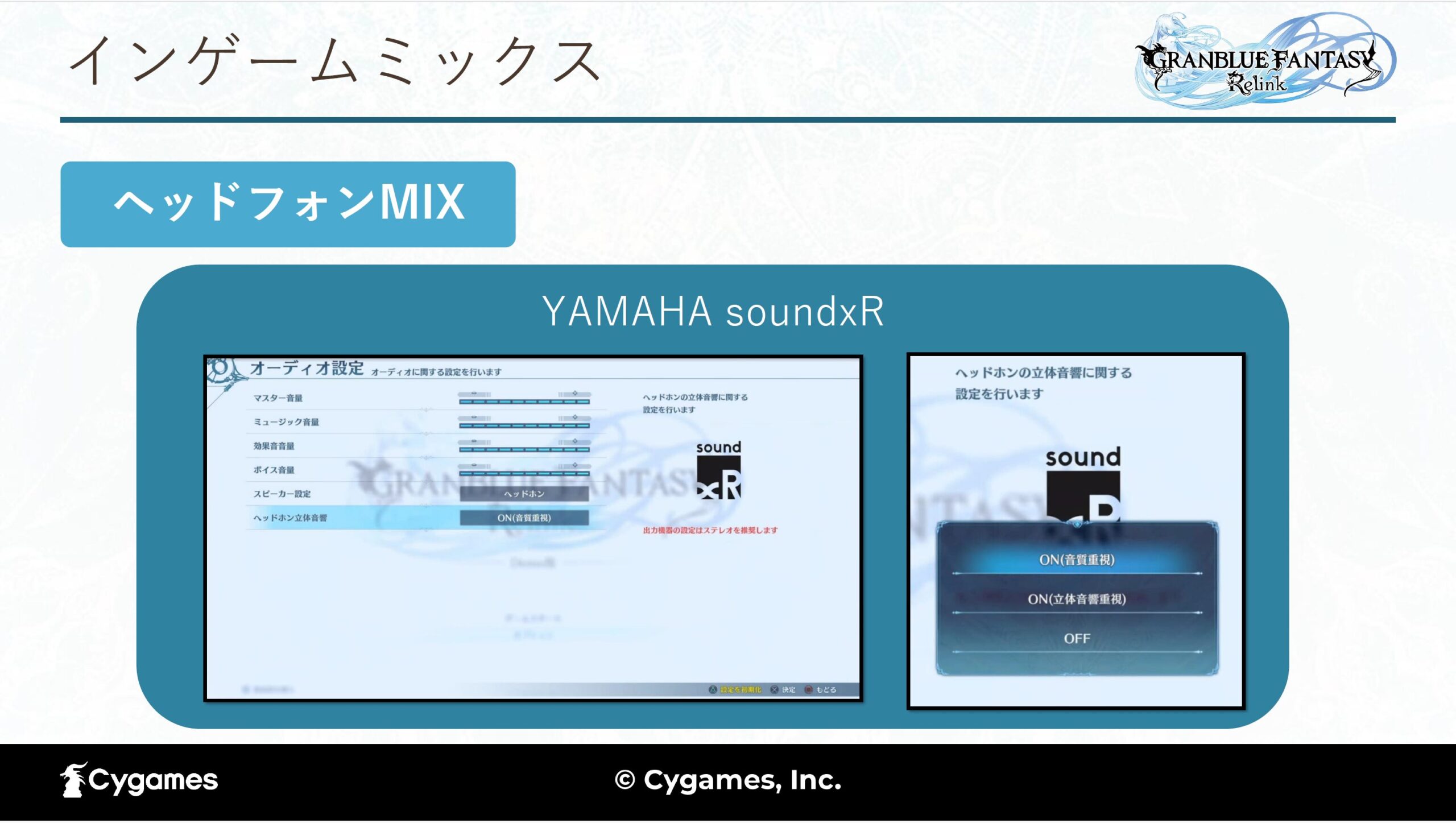

そのようにしてできた膨大なサウンド素材を元にインゲームミックスを行っていくのですが、ここで使われたのが3つの技術。まずは高さを使ったダイナミックな表現を実現するためのDolby Atmos 5.1.2、そして定位間を生かした音に包まれる表現を実現するためのAmbisonics、そして、そうしたバイノーラルサウンドをヘッドホンで手軽に再生できるようにバイノーラルに落とし込んでくれるYAMAHA SoundxRのそれぞれ。

レコーディングされたサウンドはWwiseを使ってオーサリング処理していく

レコーディングされたサウンドはWwiseを使ってオーサリング処理していく

それらをゲームに仕込んでいくために用いたミドルウェアがAudiokineticのWwise。ここに膨大に用意された波形を登録するとともに、エフェクト設定などの制御を設定し、ゲームに合わせて最大90音近くが同時に発音されるように仕込んでいった、とのことでした。

ヘッドホンでイマーシブサウンドを再現するためYAMAHAのSoundxRが利用されている

ヘッドホンでイマーシブサウンドを再現するためYAMAHAのSoundxRが利用されている

このセミナーにおいては実際のゲーム画面を見せつつ、そこでのサウンドを聴かせるもので、かなり楽しく解説を聴くことができました。

【関連情報】

Cygames公式サイト

360 Reality Audioを使った音楽作品の制作テクニック

もう一つ大阪で行われたセミナーがミキサーズラボの高田英男さんによる「360 Reality Audio 高田 英男氏による楽曲解説 〜空間の響きを活かすREC&MIX〜」。ここでは高田さんが360 Reality Audio作品にすることを前提にアコースティックスタジオで録音するとともに映像撮影も行われたボーカル作品の制作過程に関する紹介が行われました。

その作品の題材となったのはフォスター作曲名曲、Beautiful Dreamer。ご存じのとおり元は綺麗な3拍子のバラード作品ですが、それをPOPSに仕立てるというもの。そしてボーカルはteaさん。高田さんがYouTubeで見たときに、その歌唱力のすごさに圧倒されて、彼女の作品作りをしたいと思ったところ、知り合いのミュージシャンの伝手で連絡が取れてお願いすることになったのだとか。またベースとシンセサイザ、それに編曲はteaさんの旦那さんであるHiroshi Tokiedaさんが担当しているそうです。

ボーカルはteaさん、ベース、シンセサイザ、編曲はHiroshi Tokiedaさん

ボーカルはteaさん、ベース、シンセサイザ、編曲はHiroshi Tokiedaさん

さて、この制作において高田さんがまず強調していたのは、「イマーシブサウンドの制作とはいえ、もっとも重要なのはレコーディングである」ということ。とくにアコースティック楽器の場合、録音がすべてだ、と。また「空間オーディオというと、みなさんどうしても没入感とか全体が音に包まれる…といったイメージになると思いますが、僕はこの作品においてはPOPSなので、カッコいいビートを作ることを第一に考え、それをイマーシブならではの表現方法がないか模索してみました」と話されていたのも印象的でした。

その上で、事前にアレンジ構想などをミュージシャンと十分に共有した上でレコーディングに臨みます。今回のレコーディングでは東京音楽大学の中目黒校舎を使用。メインは普段はバイオリンやピアノをレコーディングするスタジオを使用。ここではタイトでクリアなサウンドが録音できるということで、タムのレコーディングの様子などが披露されました。

一方で3階のフロアにオーケストラが入る特大教室があるためアンビエントを録るためにここも併用。近接マイク、アンビエンスマイクを立ててエスニックスキャットのレコーディングの様子なども音とともに見せてくれました。

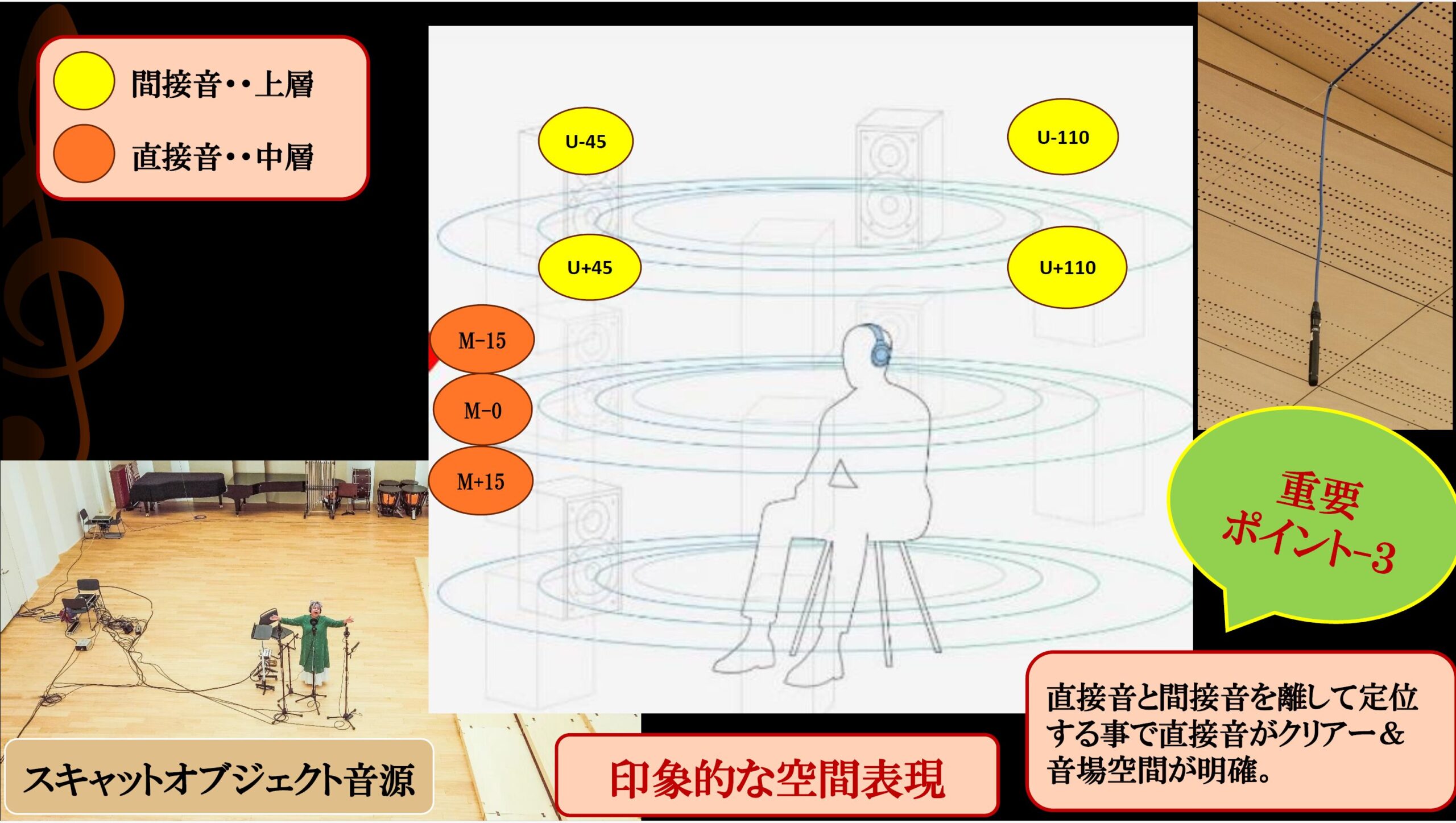

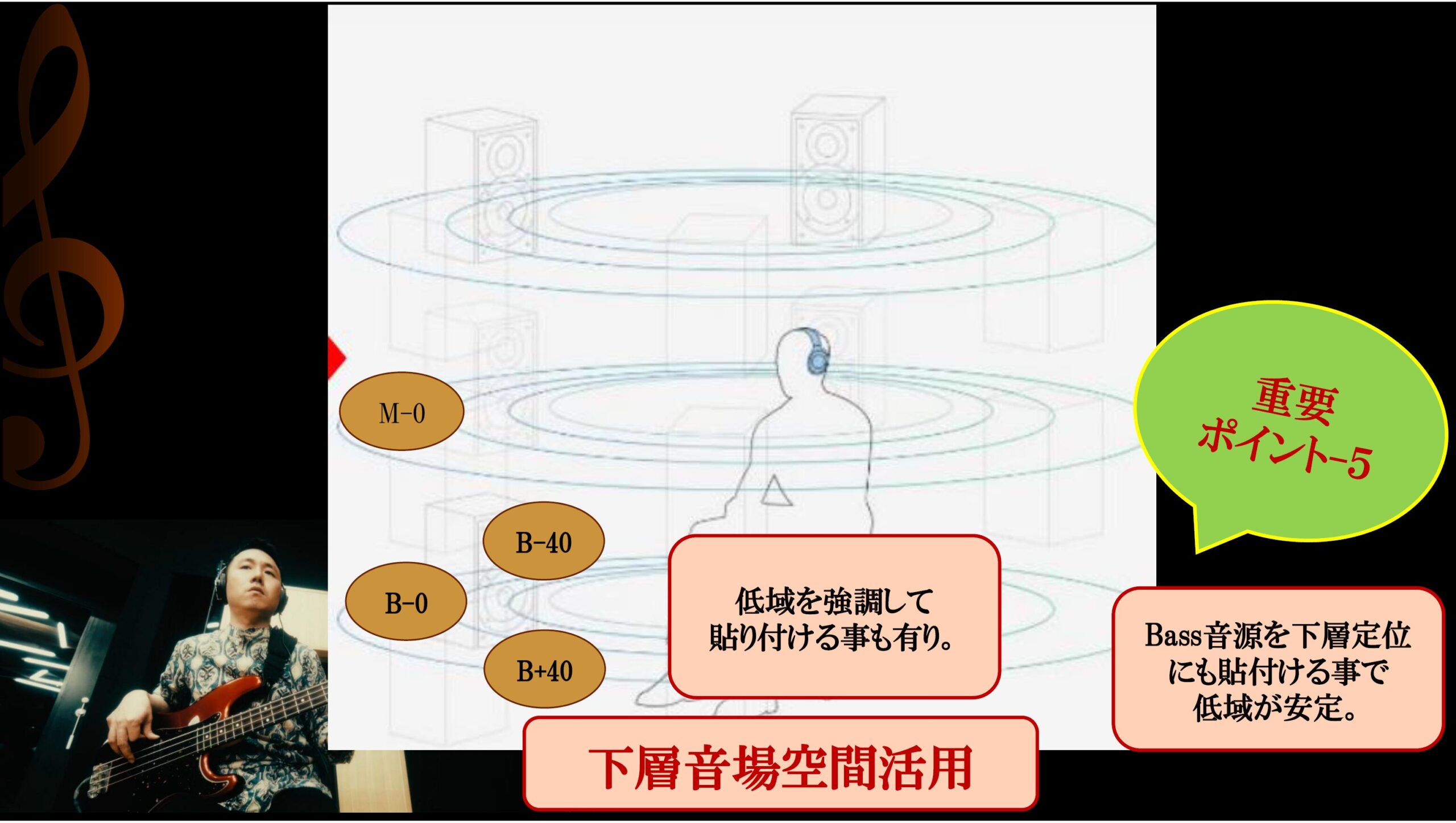

そうしたレコーディングを素材を元に360 Reality Audioを使ってのミックスを行っていきます。この際イマーシブ効果を明確に表現するために直接音と間接音を離して定位させることで空間表現効果が明確になっていく、とのこと。空間の高さ的には直接音を中層、間接音を上層に置き、ベースなどの低域を下層に配置することでサウンドの安定感も出していくことができる、と高田さん。

360 Reality Audioでのミックスでは直接音と間接音を離して定位するのがポイント

360 Reality Audioでのミックスでは直接音と間接音を離して定位するのがポイント

また360 Reality Audioはすべての音源がオブジェクト音源となるため、そのまま音源を空間に貼り付けると点音源になってしまいます。そこで同じオブジェクト音源を別定位に貼り付けることで面音源として表現するなど、いろいろなテクニックを披露してくれました。

この360 Reality Audioは360 WalkMix Creatorというプラグインを利用して制作していくのですが、これについては以前DTMステーションでも連載したことがありました。実売価格が82,500円と個人ユーザーにとってはちょっと高いのが難点。また体験版がないため、実際に試すのも難しい状況ではありますが、このAvid Creative Summit 2024に参加した人全員に、1か月使える360 WalkMix Creator Trialライセンスが配布されたのも大きなトピックスとなっていました。

【関連情報】

360 Reality Audioサイト(クリエイター向け)

360 WalkMix Creator製品情報

【関連記事】

1.DTMの世界を大きく進化させるイマーシブオーディオと360 Reality Audioの世界

2.DAWで立体的サウンドを作り上げるプラグイン、360 WalkMix Creatorの威力

3.360 WalkMix CreatorとDAWのミキサーの絶妙な関係

4.360 Reality Audioを制作するためのエクスポート手順とは

5.360 WalkMix Creatorを使い360 Reality Audioのサウンドを作ろう Cubase編

6.360 WalkMix Creatorを使い360 Reality Audioのサウンドを作ろう Studio One編

7.360 WalkMix Creatorを使い360 Reality Audioのサウンドを作ろう Logic Pro編

8.360 WalkMix Creatorを使い360 Reality Audioのサウンドを作ろう Pro Tools編

9.ドラクエ式とFF式!? 2mixでは得られない感動を作り出す、360 Reality Audioの魅力とミックス術

10.DAWで立体音響作品を作成するための360 WalkMix Creator活用テクニック

NDIを用いて東京・大阪をネットワーク接続するシステムとは

さて、今回のAvid Creative Summit 2024は、冒頭でも紹介したとおり、東京と大阪の2拠点をネットワーク接続した上で東京、大阪で交互にセミナーが実施され、双方でセミナーを受講できるようになっており、東京で行われているものが、目の前で行われているような錯覚を起こすほど、不思議な会場となっていたのですが、そのシステムがどのようになっているのか、という解説も行われました。

今回のAvid Creative Summit 2024の東京・大阪での接続システムについての解説も行われた

今回のAvid Creative Summit 2024の東京・大阪での接続システムについての解説も行われた

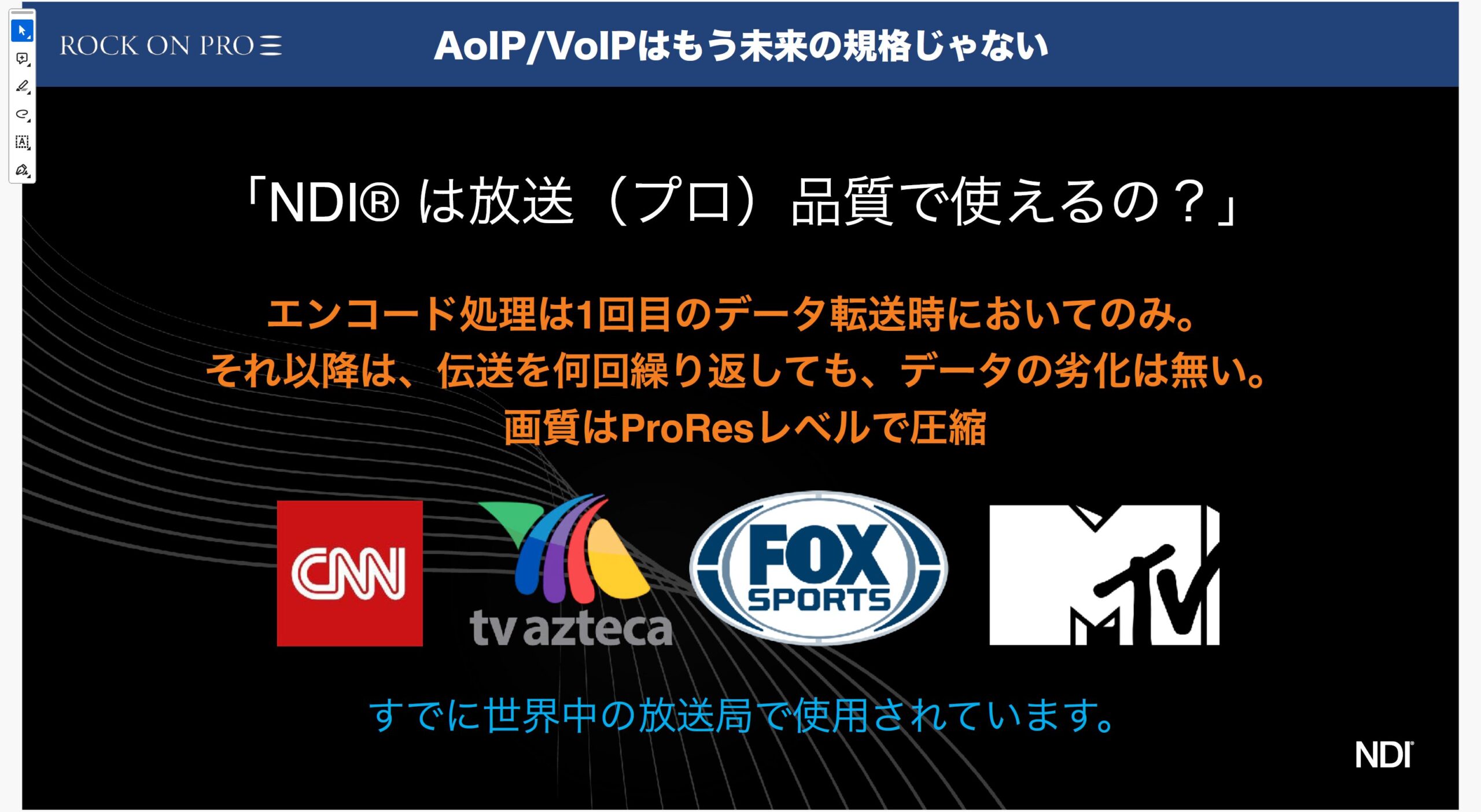

このセミナーは「AoIP/VoIPはもう未来の規格じゃない 最新ケーススタディ~NDI/SRT/ST2110/DanteAV~」と題してROCK ON PROのプロダクトスペシャリストの前田洋介さんによって行われました。

このシステムに関する解説は東京側でROCK ON PROの前田洋介さんによって行われた

このシステムに関する解説は東京側でROCK ON PROの前田洋介さんによって行われた

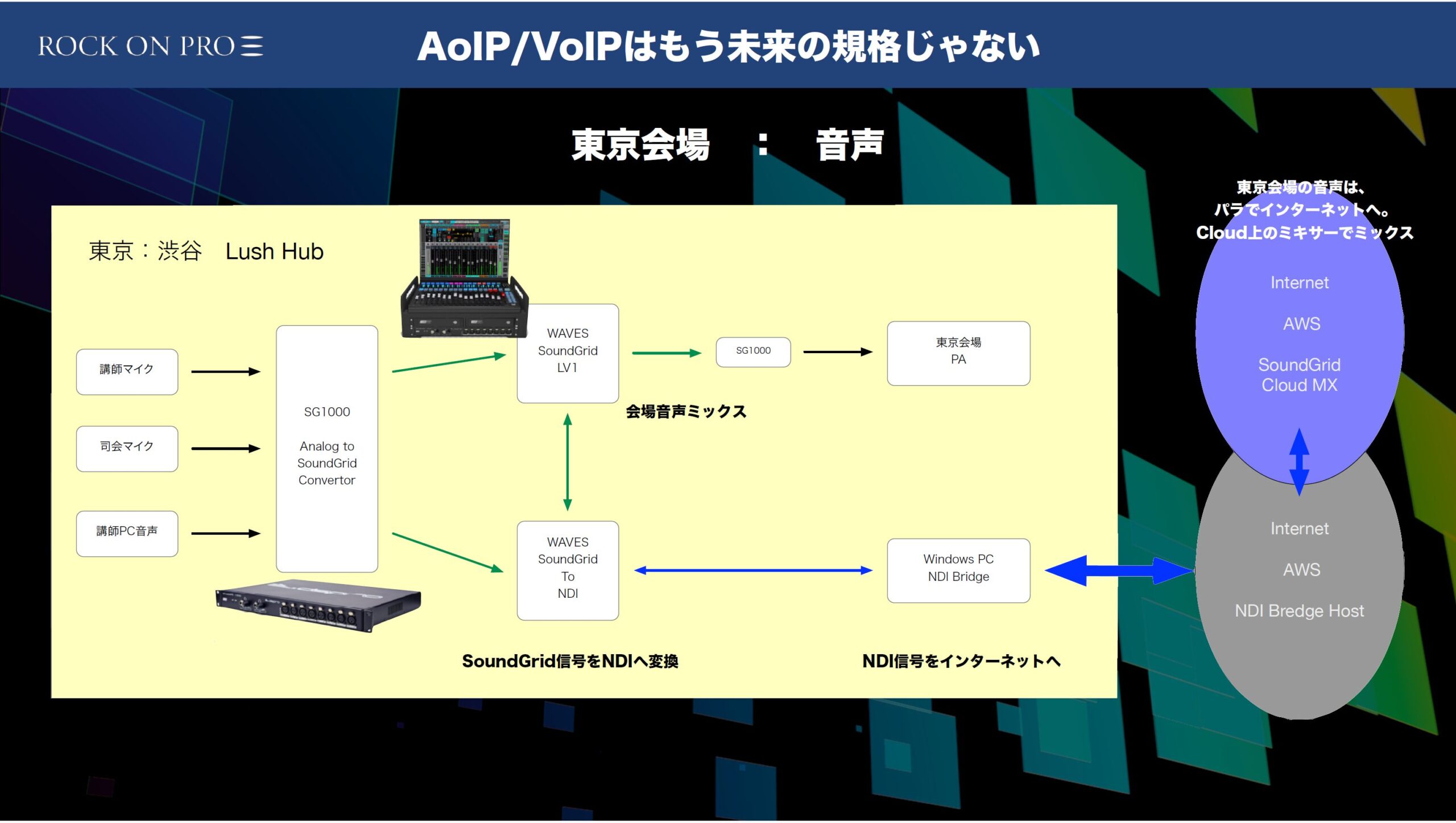

まずその音声接続ですが東京会場、大阪会場とも、ほぼ同じ構成になっており、マイク入力された音声がSG1000というSoundGridに変換するインターフェイスを経由し、さらにNDI信号に変換された上でインターネット接続されAWSへと繋がる形になっています。この際、専用線ではなく普通のインターネット回線が使用されているのが大きなポイント。

オーディオの接続図。これは東京、大阪ともほぼ同様のシステムになっている

オーディオの接続図。これは東京、大阪ともほぼ同様のシステムになっている

そのAWS上で動いているのがWAVES Cloud MXというフルスペックのオーディオミキサー。これはWAVESのeMotion LV1と同等のミキサーコンソールであり、これを使うことで東京・大阪の双方の音を細かくコントロールできるようになっているのです。

クラウド上で動かすことができるフルスペックのミックスコーンソール、WAVES Cloud MX

クラウド上で動かすことができるフルスペックのミックスコーンソール、WAVES Cloud MX

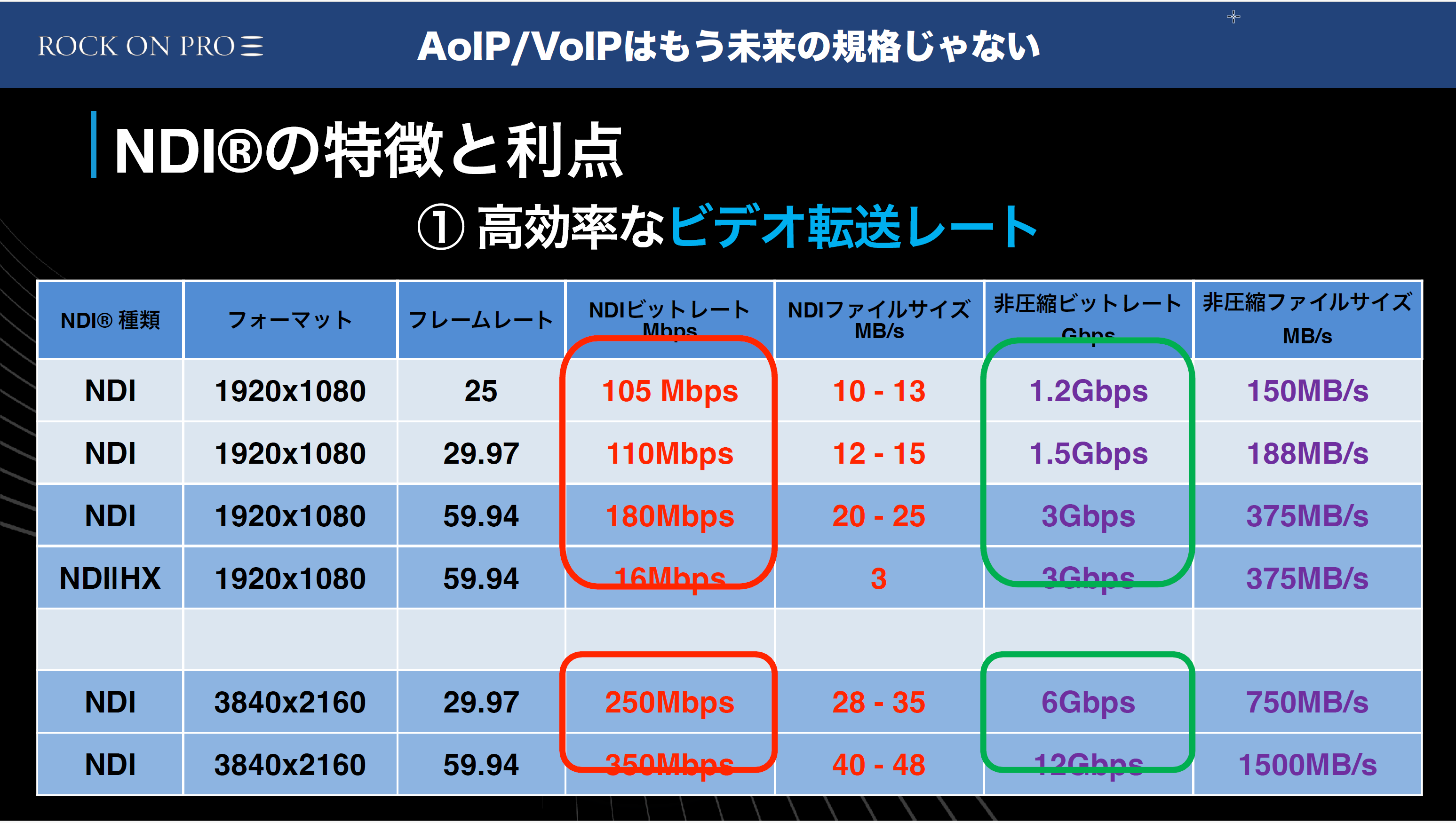

この接続に利用されたNDIはNetwork Device Interfaceの略で、NewTek社によって開発された映像、音声、制御コマンドなどをネットワーク(LAN)ケーブルで伝送できるIP伝送テクノロジーのこと。一般的なギガビットイーサネット環境で映像、音声、メタデータをNDI互換アプリケーション、デバイス、システム間でリアルタイムに相互伝送可能であることから、今回これが用いられている、とのことでした。

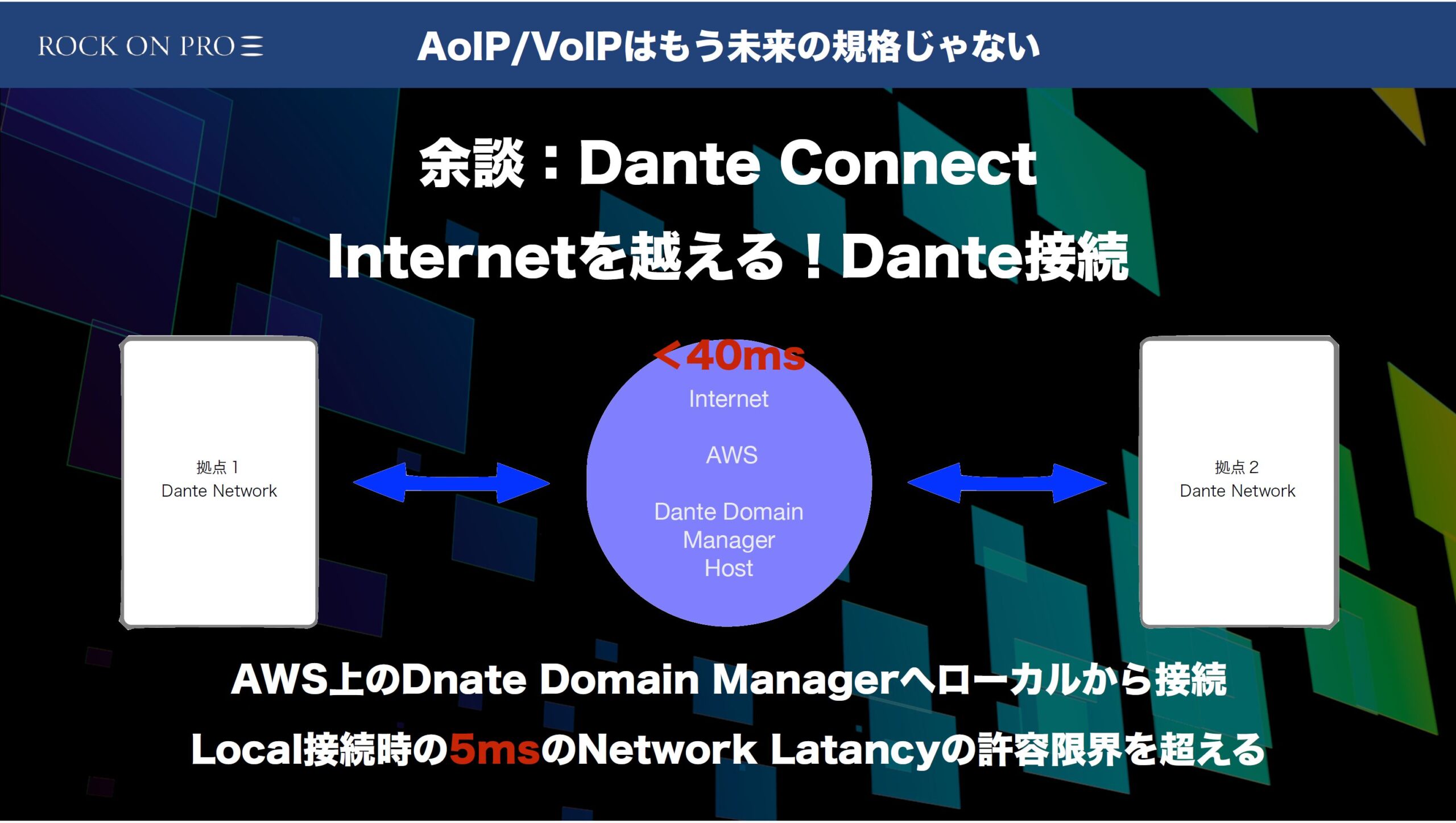

ちなみにAWS上のDante Domain Managerへローカルから接続するワザについても解説がありました。本来Danteは5ms以内のレイテンシーでないと接続できないはずですが、AWSの同期機能を利用することで世界中どことでもDante接続を可能にするトリックなども解説されました。

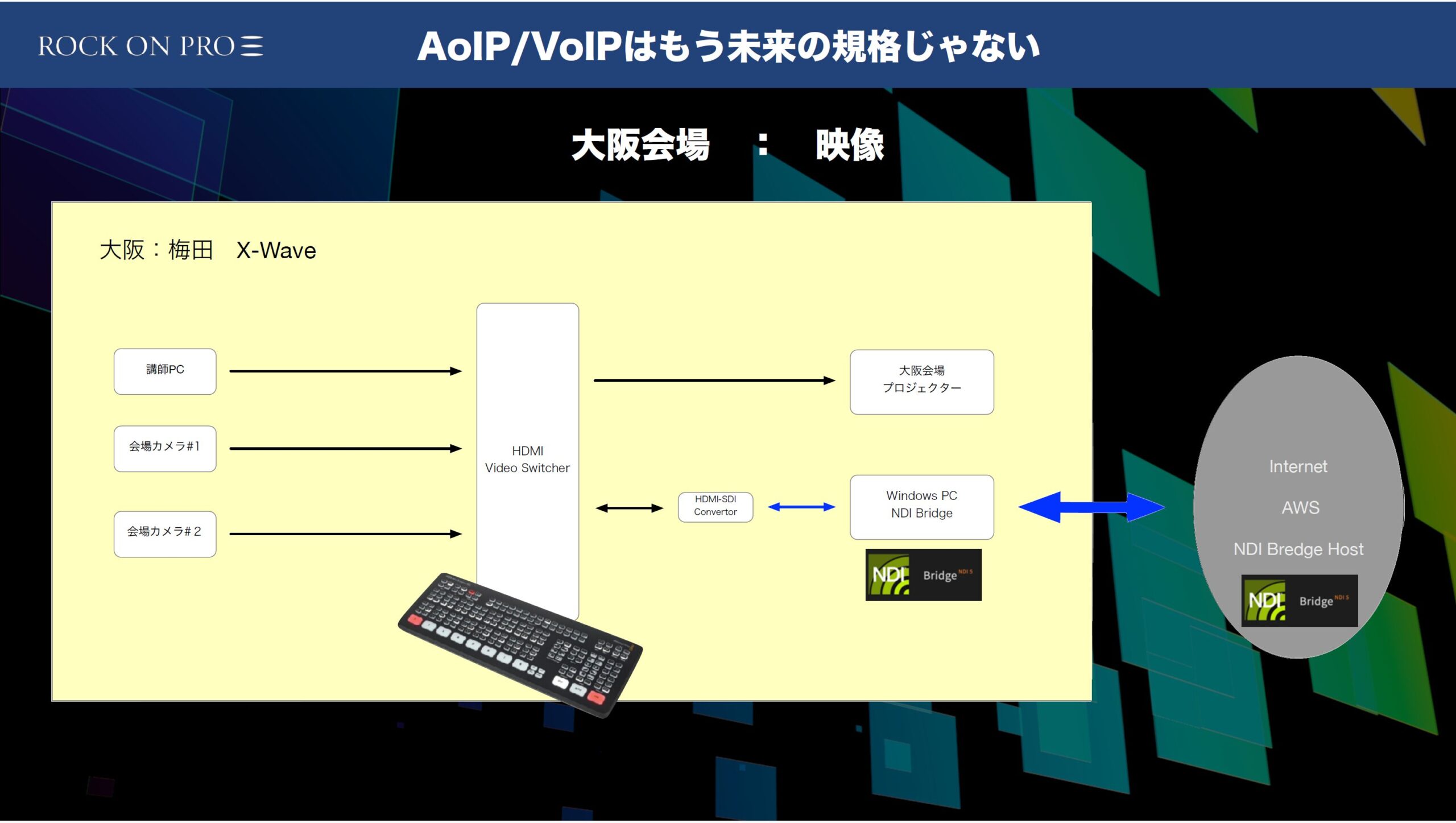

一方、映像のほうは東京会場の2台のカメラと講師PC、また大阪会場の2台のカメラと講師PCがそれぞれ別のシステムを通じてNDIに変換。音声信号とともにインターネット上のAWSサーバーへと接続され相互にやりとりされています。実際に見ていても非常に高画質な映像でしたが、圧縮が用いられており、最大3840×2160の59.94フレームのフォーマットにおいてわずか350Mbpsで伝送できるからこの東京・大阪接続ができているのだとか。

映像のシステム接続図。カメラやPCの映像がHDMIでスイッチングされたのちNDIに変換されてAWSへ

映像のシステム接続図。カメラやPCの映像がHDMIでスイッチングされたのちNDIに変換されてAWSへ

これが非圧縮だと12Gbpsにもなるため、SMPTE ST-2022やSMPTE ST-2110では通信速度的に厳しく、そのために専用回線を用意するとしても超高コストになってしまいます。またSRTであれば非圧縮映像と遜色無い画質が実現できますが、比較的遅延が大きいため、拠点間の掛け合いが必要な場面には向きません。そうした中、NDI Bridgeを使えば、画質はそこそこですが、実用に耐えうる遅延で相互中継ができ、複数地点のNDIネットワークを仮想的に1つのネットワークとして扱うことができる、それが今回のAvid Creative Summit 2024である、と紹介されていました。

NDIは映像を高圧縮できる上、遅延も少ないのが大きなメリット

NDIは映像を高圧縮できる上、遅延も少ないのが大きなメリット

以上、2月9日に行われたAvid Creative Summit 2024の一部を紹介してみましたが、いかがだったでしょうか?会場では各セミナーの終わりに講師がクジを引く形での抽選会があり、Pro Tools Ultimateの1年間ライセンスやMBOX Studio、Flux:: Spat Revolutionのライセンスなどかなり豪華なプレゼントが出ていて盛り上がっていました。全体終了時には、さらなる大抽選会が行われ、会場の半分近い人がなんらかのプレゼントをゲットしていたようでした。

大阪会場には福岡から参加したという人もいらっしゃいましたが、それだけの価値はあったように思いました。同様のイベントは今後も定期的に開催される見込みなので、ぜひ情報をチェックしておくことをお勧めします。また、今回イベントに参加された方で、気になった製品やソリューションがある方は、ぜひROCK ON PRO(https://pro.miroc.co.jp/)まで気軽に問い合わせてほしい、とのことでした。

【関連情報】

NDI公式サイト

コメント